DeepSeek AIは、長文テキストを光学的2Dマッピングによって圧縮するオープンソースシステム「DeepSeek-OCR」を開発した。これは大規模言語モデル(LLM)がテキスト量の多い入力を効率的に処理することを目的としており、「コンテキスト圧縮の新しいパラダイム」とされる。視覚的エンコーディングによって、従来のトークン化よりも効率的に情報を保存・検索できる可能性を示している。

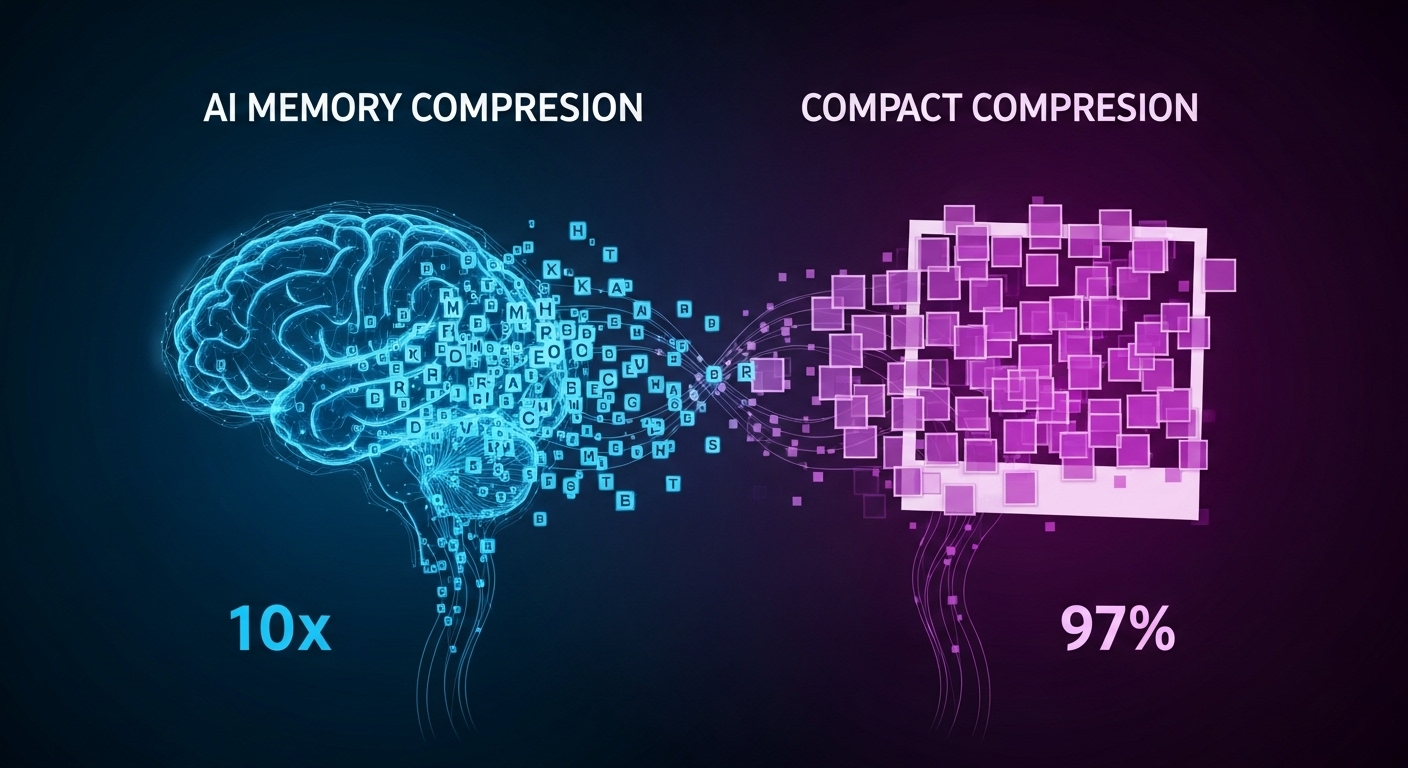

DeepSeek-OCRは、視覚圧縮を行うDeepEncoderと、Mixture-of-Experts構造を持つデコーダーDeepSeek3B-MoE-A570Mで構成される。10倍未満の圧縮率で97%のOCR精度を達成し、20倍の圧縮でも約60%の精度を維持する。DeepEncoderはウィンドウ型とグローバルアテンションを組み合わせた設計で、高解像度入力を効率的に処理できる。既存のGOT-OCR 2.0やMinerU 2.0を上回る精度を示し、1ページあたり800未満のビジョントークンで動作する。

デコーダーは専門的なタスク処理を分担するMoE構造により、速度と精度を両立している。表、数式、多言語文書の認識を高精度に行いながら、必要な計算資源を大幅に削減できる。

From: ![]() DeepSeek AI Unveils DeepSeek-OCR: Vision-Based Context Compression Redefines Long-Text Processing

DeepSeek AI Unveils DeepSeek-OCR: Vision-Based Context Compression Redefines Long-Text Processing

【編集部解説】

中国・杭州のAI企業DeepSeekが発表したDeepSeek-OCRは、AIの「記憶」問題に対する新しいアプローチとして大きな注目を集めています。この技術の革新性は、従来のテキストトークンではなく、情報を画像として保存する「ビジュアルトークン」という手法にあります。

現在のAIモデルは、会話や文書を「トークン」という小さな単位に分解して処理します。しかし、この方法には深刻な課題があります。会話が長くなるにつれて、トークン数が爆発的に増加し、計算コストが指数関数的に増大します。さらに、「コンテキスト腐敗」と呼ばれる現象が発生し、長い文脈の中間部分の情報を見落としたり、古い情報を忘れたりする問題が生じます。

DeepSeek-OCRの技術は、この問題に対する画期的な解決策を提示しています。テキストを画像に変換してから処理することで、10倍圧縮で97%の精度を維持し、20倍圧縮でも60%の精度を保つことができます。

この技術のもう一つの興味深い側面は、「階層的圧縮」という仕組みです。人間の記憶が時間とともに徐々に薄れていくように、AIも古いコンテキストをより低い解像度で保存します。重要な最近の情報は高解像度で保持し、古い情報は圧縮率を上げることで、効率的でありながら実用的な記憶システムを実現しています。

技術的には、DeepEncoderという約380Mパラメータのエンコーダーと、DeepSeek-3B-MoEという570Mアクティブパラメータのデコーダーから構成されています。エンコーダーは文書を画像として圧縮し、デコーダーがそれを正確なテキストに復元します。この仕組みは、100言語にわたる3,000万PDFページでトレーニングされており、多言語対応も実現しています。

実用面での性能も注目に値します。単一のNVIDIA A100 GPUで1日あたり20万ページ以上のデータを処理でき、20ノード構成(160 GPU)では1日3,300万ページという驚異的なスループットを達成しています。これは、大規模言語モデルのトレーニングデータ生成において極めて重要な能力です。

OpenAIの元AIチーフであり、OpenAIの創設メンバーでもあるAndrej Karpathyは、この論文をX(旧Twitter)で称賛し、画像がLLMの入力としてテキストより優れている可能性があると指摘しました。ノースウェスタン大学のManling Li助教授も、画像ベースのトークンを用いたコンテキスト保存のアイデアをここまで発展させた初の研究だと評価しています。

この技術の応用可能性は広範囲に及びます。AIエージェントの長期記憶、大規模文書の効率的な処理、トレーニングデータの大量生成など、多くの分野での活用が期待されています。特に、金融、科学、医療といった分野では、表やグラフなどの視覚的情報を効率的に処理できる点が大きな利点となります。

ただし、研究チームも認めているように、これは初期段階の探索的研究です。今後は、推論タスクへのビジュアルトークンの適用や、より動的な記憶の衰退メカニズムの実装など、さらなる発展が期待されています。現在のシステムは、最も重要な情報ではなく、最も新しい情報を優先的に記憶する傾向があるため、人間の記憶のように重要度に基づいた動的な記憶管理の実現が次の課題となるでしょう。

DeepSeekは2025年1月にDeepSeek-R1という推論モデルをリリースし、OpenAIのo1モデルに匹敵する性能を95%低いコストで実現して業界に衝撃を与えました。今回のDeepSeek-OCRも、その延長線上にある革新的な研究成果と言えます。AIの効率性と実用性を追求する同社の姿勢は、今後のAI業界全体に大きな影響を与えていくでしょう。

【用語解説】

トークン

AIモデルがテキストを処理する際の最小単位。単語や単語の一部、記号などに分割される。大規模言語モデルは、このトークン数に基づいて処理コストが決まる。

コンテキスト腐敗(Context Rot)

AIモデルが長い入力を処理する際に、情報を正確に保持できなくなる現象。特に入力の中間部分の情報が失われやすく、会話が長くなるにつれて以前の情報を忘れたり、情報が混乱したりする問題。

ビジュアルトークン

テキスト情報を画像形式で表現したトークン。DeepSeek-OCRでは、従来のテキストトークンの代わりにビジュアルトークンを使用することで、大幅な圧縮を実現している。

OCR(光学文字認識)

画像やスキャンした文書から文字を抽出し、機械が読み取れるテキストデータに変換する技術。スキャナーアプリや翻訳アプリなどで広く使われている。

MoE(Mixture of Experts)

複数の専門的なニューラルネットワーク(エキスパート)を組み合わせたAIアーキテクチャ。入力に応じて最適なエキスパートを選択することで、効率的な処理を実現する。

DeepEncoder

DeepSeek-OCRのコア技術となる約380Mパラメータのビジョンエンコーダー。高解像度入力を処理しながら、低いアクティベーションメモリと少ないビジョントークンを維持する設計。

【参考リンク】

DeepSeek-OCR GitHub(外部)

DeepSeek-OCRの公式リポジトリ。コード、モデルの重み、実装方法が公開されており、誰でもアクセス可能

DeepSeek-OCR論文(arXiv)(外部)

コンテキストの光学圧縮に関する技術論文。ビジュアルトークン圧縮の詳細な手法と実験結果を掲載

DeepSeek-R1 GitHub(外部)

2025年1月にリリースされたDeepSeekの推論モデル。OpenAIのo1に匹敵する性能を実現

DeepSeek-OCR Hugging Face(外部)

Hugging Faceプラットフォームでホストされているモデル。ダウンロードと実装が容易に行える

DeepSeek API Documentation(外部)

DeepSeekの各種モデルのAPI仕様書。開発者向けの技術ドキュメントとガイドを提供

【参考記事】

DeepSeek drops open-source model that compresses text 10x through images – VentureBeat(外部)

単一のNVIDIA A100-40G GPUで1日20万ページ以上を処理可能。20サーバークラスタでは1日3,300万ページに達する。

Context Rot: How Increasing Input Tokens Impacts LLM Performance – Chroma Research(外部)

18のLLMを評価し、入力長が増加するにつれてモデルのパフォーマンスが著しく変化することを実証した研究。

New Deepseek model drastically reduces resource usage by converting text and documents into images – Tom’s Hardware(外部)

金融、科学、医療分野での表形式データやグラフの処理に特に有用と分析。10倍未満の圧縮率で97%の精度達成。

Open-source DeepSeek-R1 uses pure reinforcement learning to match OpenAI o1 at 95% less cost – VentureBeat(外部)

DeepSeek-R1がOpenAIのo1モデルと同等の性能を90-95%低いコストで実現。MITライセンスで公開。

DeepSeek OCR is here – Medium(外部)

10倍圧縮で約97%の精度を維持し、事実上ロスレスであることを解説。20倍圧縮でも約60%の精度を保持する。

5 Approaches to Solve LLM Token Limits – Deepchecks(外部)

2025年時点の主要LLMのトークン制限を整理。Gemini 1.5 Proが100万トークン、Claude 3.5が20万トークン。

【編集部後記】

AIと長時間会話していて、途中で話の筋が見えなくなった経験はありませんか。DeepSeekのこの研究は、その問題に真正面から取り組んでいます。興味深いのは、人間の記憶が時間とともに薄れていくように、AIにも「忘れる」仕組みを組み込んでいる点です。私たちは重要な記憶は鮮明に覚えていても、些細な記憶は曖昧になっていきます。AIがそれを模倣できるなら、より自然で効率的な対話が実現するかもしれません。テキストを画像として保存するというアイデアは、一見突飛に思えますが、実は理にかなっています。みなさんは、AIの「記憶」がどう進化していくと考えますか。この技術が日常のAI利用にどんな変化をもたらすか、一緒に想像してみませんか。