Stable Diffusionの規制が強まる今、次世代の画像生成AIとして注目されているものの一つがFLUX.1です。FLUXはStable Diffusionと同様に、完全無料でローカルの環境で利用することができるのが特徴です。今回は、このFLUXを「ComfyUI」というUI上で利用するための手順について解説します。

FLUX.1とは?

「FLUX.1」とは、元Stable Diffusion開発チームだったメンバー数名によって立ち上げられた企業である「Black Forest Labs」が開発した新たな画像生成AIモデルです。

Stable Diffusionほどオープンなモデルではありませんが、ベースとなるモデルとウェイトは公開されているため、コミュニティによる研究開発が盛んな画像生成AIです。Stable Diffusionからののれん分けという立場から、ユーザーの流入も多く、まだ比較的歴史が浅いとは言え、すでにある程度のマージモデルなどが流通しています。

また、FLUXも同様に「拡散モデル」であり、入力されたプロンプトをもとに、ランダムなノイズ画像から画像を生成する仕組みですが、大きく異なる点として、Stable Diffusionが単語や短文と画像を結び付けて学習させる、LAIONが開発した「OpenCLIP」を使用していたのに対して、FLUXはGoogleの「T5」をベースにしたもの利用しており、画像を単語や短文のようなタグとの関連性ではなく、キャプション的な文章とリンクして学習している点です。

そのため、こちらがAIにわかりやすいような単語をプロンプトとして入力する必要があったのに対し、私たちの普段の言葉遣いを理解しやすくなっています。加えて、以前のような単語ベースのプロンプトもしっかりと効くようになっています。こちらのほうが、生成処理の段階で、文章がテキストエンコーダーを通じ、最終的なプロンプトとして調整される段階で情報が失われることが少ないため、重要な要素は変わらず単語ごとに入力するといった使い分けが重要になります。

目次

はじめに

FLUXはStable Diffusionで最もメジャーなUIとして知られる「AUTOMATIC1111」に対応していません。

「WebUI Forge」という、AUTOMATIC1111から派生し、より軽量に使いやすくというコンセプトで開発されたUIに対応しています。こちらのほうがStable Diffusionに馴染みのある人には移行しやすいかもしれませんが、今回はあえて「ComfyUI」という風変わりなUIでの利用方法について解説していきます。

というのも、後ほど詳しく解説しますが、ComfyUIのほうが自由度が高いからです。比較的低コストで、オープンな部分が多かったStable Diffusionよりも、FLUXのような後出のややハイスペックで複雑なモデルを運用するには、ComfyUIが最も適していると言えます。

その分導入手順や、使い方も複雑にはなってしまいますが、ここは使ううちにすぐ慣れると思います。これも、その理由について詳しいことは後ほど解説します。

そして、ローカルで利用できるFLUXには「Schnell(シュネル)」と「Dev(デヴ)」という二つのモデルが存在します。

それぞれの特徴をまとめると以下のようになります。

| Schnell | Dev |

|---|---|

| 高速・軽量モデル | 高品質・開発者向けモデル |

| 商用利用が可能 | 商用利用は原則不可 |

| SD3.5より低クオリティ | SD3.5より高クオリティ |

SchnellはApache2.0ライセンスの元、商用利用が可能となっています。

Devの商用利用の原則禁止とは、Devの学習モデル、およびその派生モデル自体を商用利用することを禁止するものであり、生成した画像の商用利用は可能です。これは2024年8月にライセンスが変更され、2025年6月に現在の文面に整えられたことで明言されたライセンスのため、「一切の商用利用ができない」というのは過去の情報になります。

ただ、注意すべき点としては、顧客から「こういう画像を作ってほしい」という依頼に対して、Devモデルを使用して生成した画像を納品することは「モデル自体の商用利用」とみなされる可能性がありますので、詳しくは公式ライセンスや、弁護士など専門家の意見を確認してください。

FLUX.1-dev非商用ライセンス|HuggingFace(外部サイト)

以下はローカルでFLUXを利用するために必要なパソコンスペックの目安になります。FLUXには先述の通り、規模の違うモデルがあり、更に「量子化」というさらなる軽量モデルもあるので、一概にこれだけあれば絶対十分!というラインはないということを念頭に入れておいていただきたいです。

最低環境(ギリギリ動かせる)

| OS | Windows10 64bit |

| GPU | NVIDIA GeForce RTX 4060 (VRAM 8GB) |

| 容量 | 30GB以上の空き SSD推奨 |

| CPU | Intel Core i5 第8世代 AMD Ryzen 5 2600 |

| メモリ | 16GB |

推奨環境(快適に利用できる)

| OS | Windows10 64bit |

| GPU | NVIDIA GeForce RTX 4090 (VRAM 24GB) |

| 容量 | 100GB以上の空き SSD推奨 |

| CPU | Intel Core i9 第13世代 AMD Ryzen 9 7900X |

| メモリ | 64GB |

上の表はあくまで目安です。設定の最適化や、モデルなどによって必要なスペックは大きく変わります。最も重要なのは「NVIDIAのCUDA対応のGPUが搭載されていること」と「SSD」と「十分なメモリ」になります。FLUXはテキストエンコーダーの処理がStable Diffusionよりも複雑になるため、必要なメモリ領域がその分増えています。

導入方法

今回は「Stability Matrix」から「ComfyUI」をダウンロードする方法を紹介します。直接ComfyUIのみの環境を構築することもできますが、Stability Matrixがあれば、今後Stable DiffusionやHiDreamといった他の画像生成AIが使いたくなった時、Stability Matrixならモデルなどが一括管理でき、使いまわせるので容量の節約にもなりますし、AUTOMATIC1111やForgeといったUIのインストールも簡単にできますし、初めての人にはややこしいPythonやgitのインストールといったことも簡単にできるのでおすすめです。

デメリットとしては、各UIの更新が反映されるまでのタイムラグがあることですが、どうしても最新をその日のうちに絶対試したくて仕方がない!という人や、Pythonをバリバリ使って自分だけの環境を構築したい上級者でもなければStability Matrixを使いましょう。

Stability Matrixのインストール方法は過去の記事で紹介していますので、詳しくはそちらもご確認ください。

まずはGitHubからStability Matrixをダウンロードし、展開しましょう。そしてインストールするUI一覧の中からComfyUIを選択してインストールします。

Stability Matrix | GitHub(外部サイト)

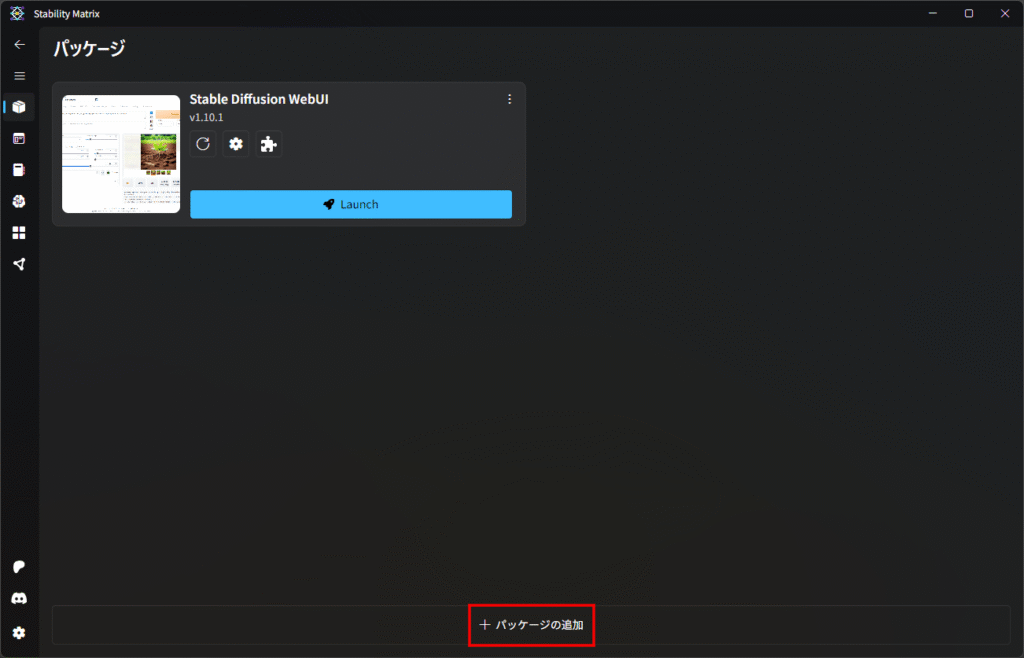

すでにStability Matrixをインストールしている人はパッケージから「追加」を選択して、インストールします。

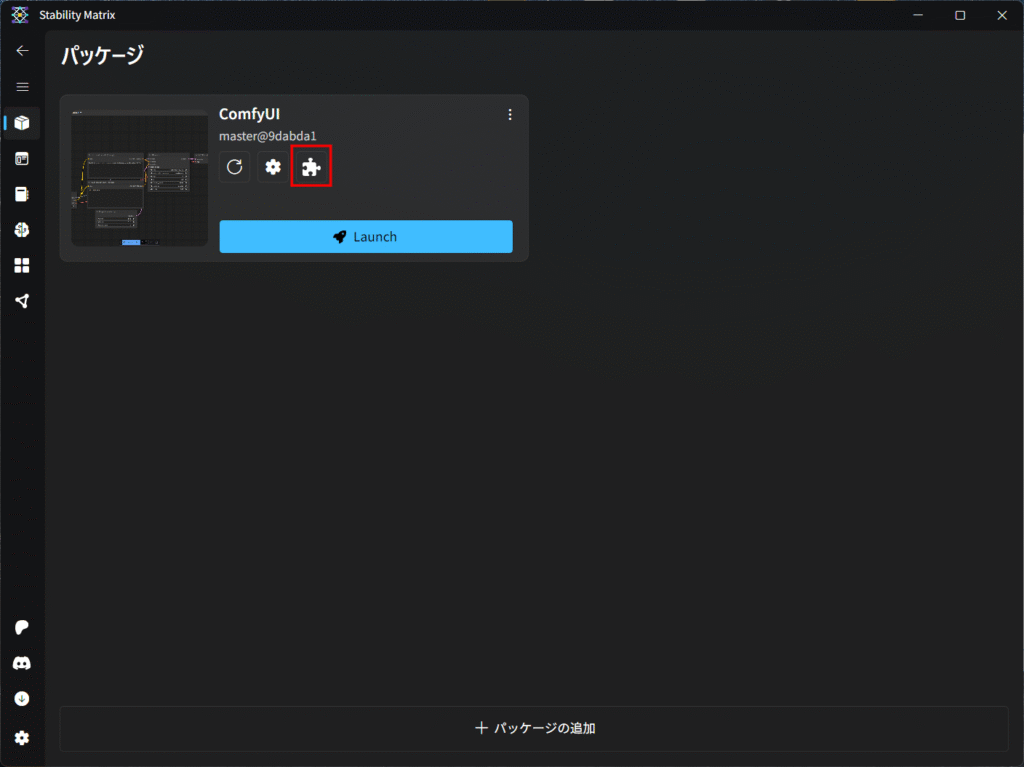

インストールが完了したら、パッケージの一覧に表示されます。次は「ComfyUI Manager」をインストールします。すぐに必要というわけではありませんが、使い込んでいくにはほぼ必須なので最初にインストールしてしまいましょう。

パッケージ一覧のComfyUIのカードにあるパズルのピースのようなアイコンをクリックします。

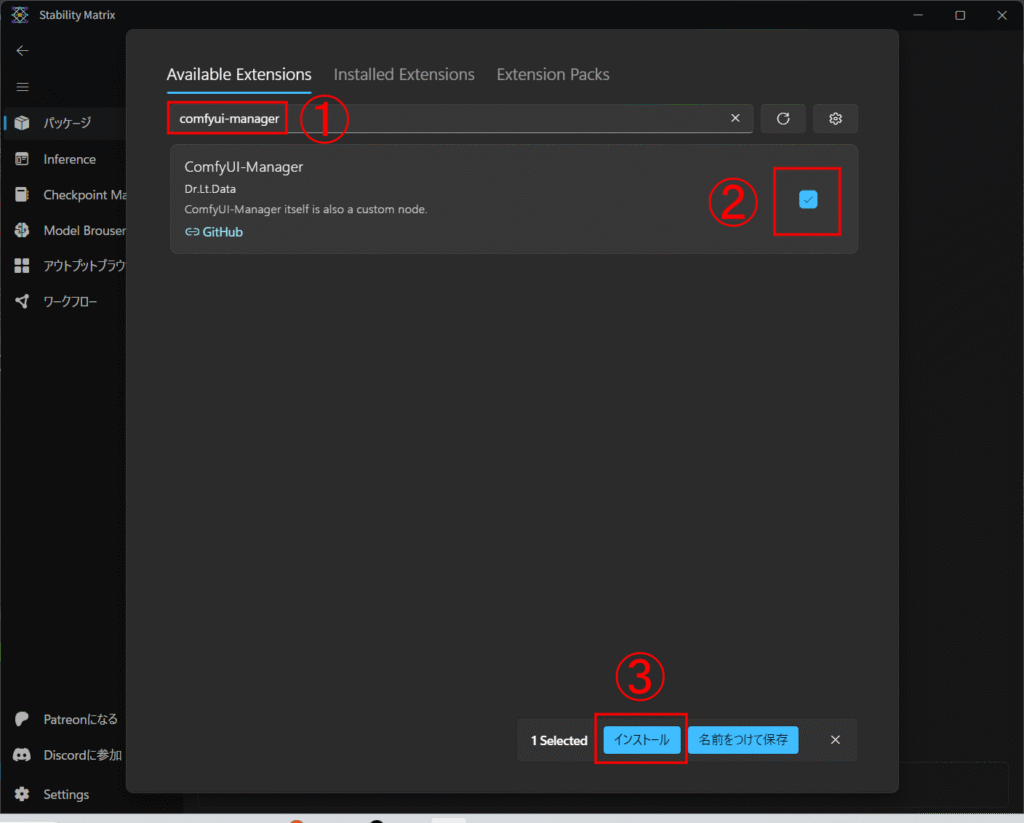

そうしたら「ComfyUI-manager」で検索し、出てきたものにチェックを入れてインストールします。

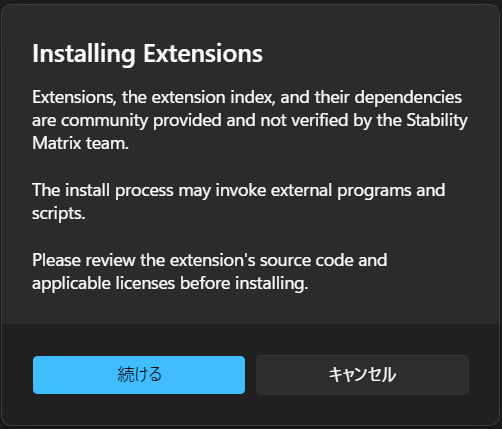

そうすると警告が出てきます。ComfyUI Managerなどの拡張機能は様々なユーザーがつくったものが公開されていて、Stability Matrixはそれらをダウンロードするのを補助するためのマネージャーアプリにすぎません。なので、中にはウイルスなどが仕組まれている可能性があります。それについてStability Matrixは責任を取りません。といった警告です。今回はそのまま続けて問題ありません。

インストールが完了したら、ComfyUIを開いてみましょう。パッケージ一覧から「Launch」をクリックして起動させます。

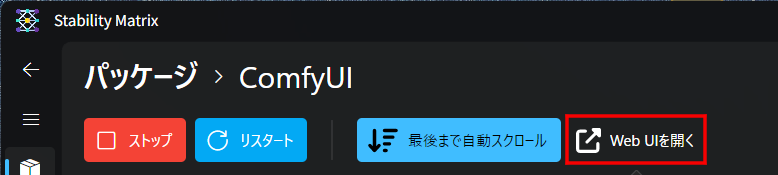

ズラズラとログが出てきて、しばらくすると上に「Web UIを開く」ボタンが表示されますので、これをクリックするとブラウザでComfyUIが起動します。

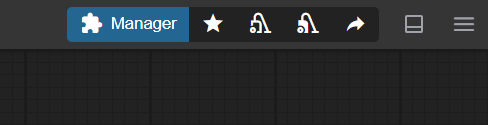

画面右上に青色の「Manager」ボタンがあれば、ComfyUI Managerのインストールも完了しています。

最初は何もないマス目の画面だけが表示されていると思いますが、ここがワークスペースになり、ここに様々なノードを配置し、それらをつなぎ合わせていくのがComfyUIの使い方になります。

それでは、まずモデルとテキストエンコーダーをダウンロードしましょう。

FLUX.1-schnell|Hugging Face(外部サイト)

FLUX.1-dev|Hugging Face(外部サイト)

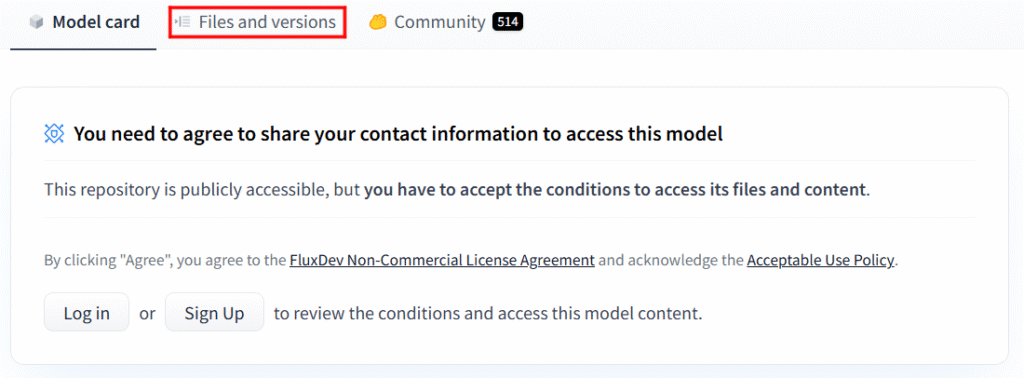

公式モデルのダウンロードにはHuggingFaceのアカウントと、利用規約への同意が必要となります。

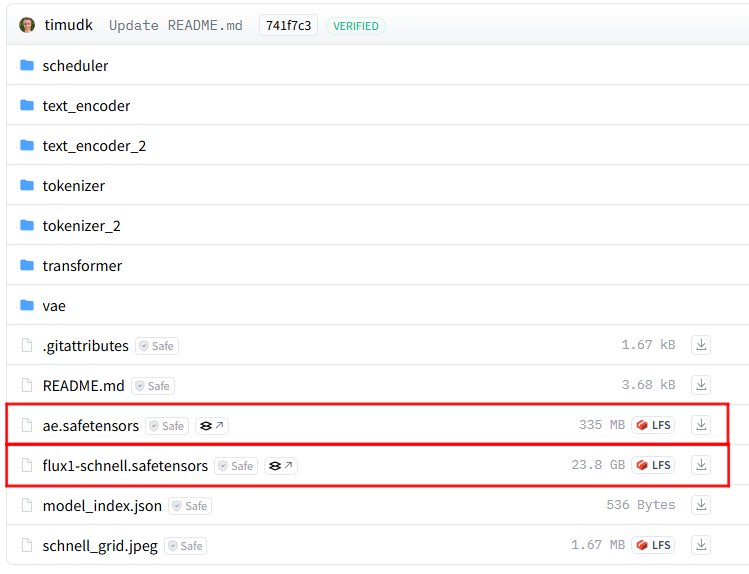

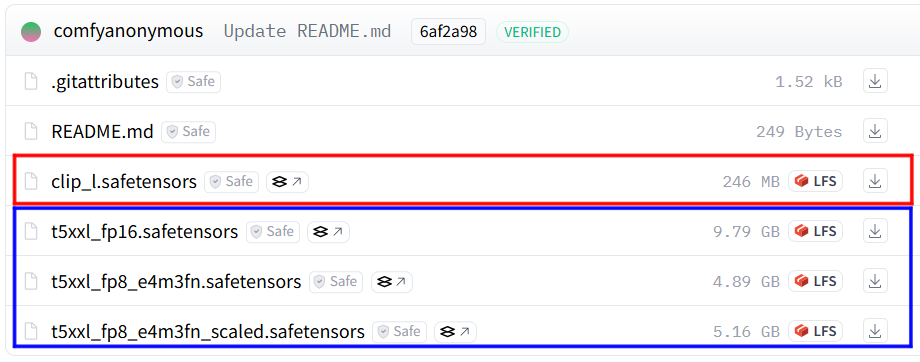

このような通知が出てきますので、ログインした状態で利用規約に同意した後、「Files and versions」タブをクリックします。

「ae.safetensors」と「flux1-schnell(dev).safetensors」を一番右側のアイコンをクリックしてダウンロードします。

「ae.safetensors」はVAEと呼ばれるもので、簡単に説明すると、拡散モデルの画像生成AIにおいて、生成の最後に画像を整えるために必要なファイルです。モデルによってはVAEが最初からモデルのほうに組み込まれていて不要なこともありますが、今回ダウンロードする公式のモデルには別添えで必要なものになります。

VAEの保存先

StabilityMatrix-win-x64\Data\Models\VAE

モデルデータの保存先

StabilityMatrix-win-x64\Data\Models\DiffusionModels

次はテキストエンコーダーをダウンロードしましょう。

FLUX-Text-Encoder|Hugging Face(外部サイト)

まずは「clip_l.safetensors」が必須で、青枠の中の「t5xxl」はどれか一つがあれば十分です。

何が違うのか?と言われると、性能が違います。fp16>>fp8 scaled>fp8となっており、fp16が最も高性能ですが、その分処理の負荷が大きくなります。念のためすべてダウンロードして、いろいろ試してみるのがいいと思います。

テキストエンコーダーの保存先

StabilityMatrix-win-x64\Data\Models\TextEncoders

これで画像生成に必要最低限のものはそろいましたので、次はComfyUIに移って画像を生成してみましょう。

利用方法

さぁ、画像生成をしましょう。といっても、ComfyUIにはまだ何もないと思います。なので、ComfyUIの開発者がGitHubでFLUXの使用例を紹介しています。英語ではありますが、ブラウザの翻訳機能を使えば十分理解できる内容だと思います。

また、このページには「FP8」という軽量モデルも紹介されています。schnellでも重くて使い勝手が悪い、と思ったら試してみるのもいいかもしれませんが、当然生成画像のクオリティも下がりますのでご注意ください。

まずはschnellを例として説明します。

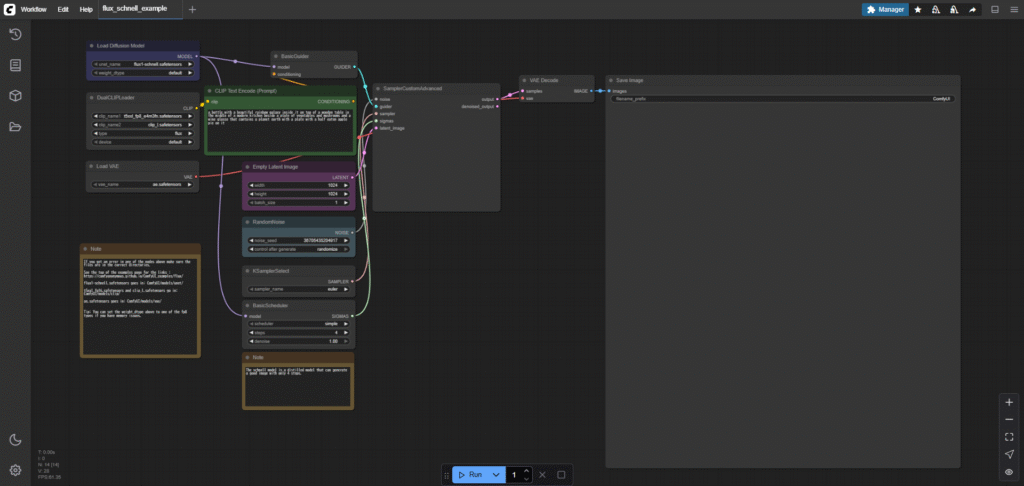

上記リンク先のページで、上から2番目の「Flux Schnell」見出しの下にある、鮮やかな瓶の画像をComfyUI上にドラッグしてみましょう。(画像を保存する必要はありません。)

すると、以下のようなものが表示されるかと思います。この線でつながったカードがノード(カスタムノード)と言われるものです。

もしなにか足りないデータがあると表示が出ます。GitHubやHuggingFaceで入手できるものなら、ここでまとめてダウンロードすることもできます。

このまま、下の「Run(実行)」ボタンを押せばサンプルと同じ画像が生成されます。

このように、ComfyUIで生成した画像は、その情報がメタデータとして画像に保存されるため、ほかの人が生成した画像で気に入ったものがあれば、どのようなフローになっているのか、どのようなプロンプトを用いているのかがわかるようになっています。(もちろん消されていたら見れませんが…)

このため、ComfyUIは難しそうに見えても、生成画像のプロセスを見ることができるので、いろいろ見ていくうちに自然と身につくものが多いでしょう。

今回はサンプル画像なので、ノードやフロー自体も至ってシンプルです。AUTOMATIC1111などを利用したことがある人は見覚えのあるような内容になってるかと思います。

それぞれのノードを一つずつ解説します。

「Load Diffusion Model」

読み込む拡散モデル(学習モデル)を選択します。

「DualCLIPLoader」

FLUXはStable DiffusionのようなCLIPとT5の二つを利用してプロンプトを処理しているため、Dualである必要があります。

「Load VAE」

読み込むVAEを選択します。

「CLIP Text Encode(Prompt)」

プロンプトを入力するところです、プロンプトは「, 」(半角カンマと半角スペース)で区切ることで区別させます。

「Empty Latent Image」

生成する画像のサイズを指定します。数字は8の倍数である必要があります。

「Batch_size」は一度に何枚同時に生成するかの設定です。大きくすれば当然パソコンにかかる負担が大きくなります。

「RandomNoise」

毎回ランダムな画像を生成するためのシード値の設定ができます。「control after generate」によって、画像を生成した後にシード値を「固定する(fixed)」「1増やす(increment)」「1減らす(decrement)」「ランダムに変える(randomize)」から選べます。

「KSamplerSelect」

画像からどうやってノイズを除去していくのか指定できます。よくわからなかったら「euler_ancestral」がおすすめです。

「BasicScheduler」

ノイズ除去をどういうペースで行うのかを指定できます。よくわからなかったら「karras」がおすすめです。

「steps」は何回ノイズ除去をするかの設定です。多ければ多いほどきれいな画像になる傾向ではありますが、最大でも25程度やれば、以降はほとんど違いは出ません。schnellはこれが4で済むというのが売りです。

「denoise」は画像から何%ノイズを取り除くかという指定です。例えば、0.7にすると、プロセスのうち、最初の30%は何もせず、後半70%はノイズを取り除いていくことになります。プロンプトから画像を生成するText-to-Image(T2I)ならほぼ必ず1.0、すでにある画像から新たな画像を生成するImage-to-Image(I2I)なら調整する必要があります。

「BasicGuider」

モデルとコンディショニング(テキストエンコーダーを通したプロンプト)を受け取り、画像の設計図(Guider)を渡すような処理が行われます。

「SamplerCustomAdvanced」

上記のGuiderと、様々な処理を受け取り、潜在画像という、人間が見ても意味不明な、圧縮された画像を生成する処理が行われます。

「VAE Decode」

最後に潜在画像を視覚的な情報を持った画像へと復元する処理が行われます。

「Save Image」

出来上がった画像が表示されます。

ComfyUIの自由度とは、この細かいプロセスの一つ一つを設定することが容易だということです。ComfyUIに最初から備わっているノードだけでなく、ComfyUI Managerによってユーザーが作成した様々なノードをダウンロードして組み合わせていけば、より詳細に生成される画像をコントロールすることができます。

使いこなせれば、画像だけでなく、動画や音声、3Dモデルなども生成できますし、学習などもこなせます。

ノードを追加するには、ワークスペース上で右クリックして「Add Node」を選択するか、左側バーの上から2番目のアイコンから「NODE LIBRARY」から検索するかの方法があります。線はドラッグアンドドロップで引くことができます。

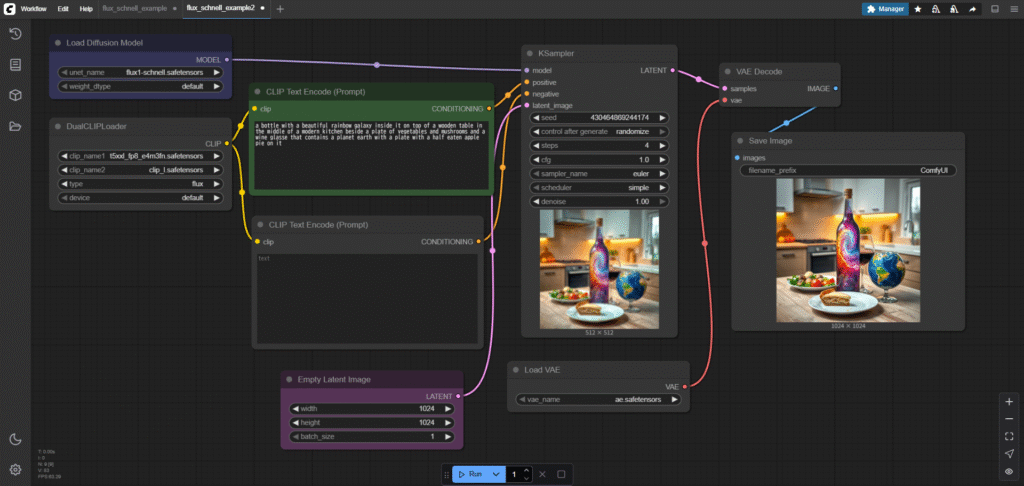

たとえば、このサンプルを少し改造して、少しさっぱりさせつつ、ネガティブプロンプトを入力できるようにしてみましょう。

※基本的にノードの接続する点は、左側にあるのが入力で、小文字で書かれており、右側にあるのが出力で、大文字で書かれています。

1.「BasicGuider」と「RandomNoise」と「KsamplerSelect」と「BasicScheduler」と「SamplerCustomAdvanced」を削除してしましましょう。ノードをクリックするとその真上に赤いゴミ箱マークが出るのでこれをクリックして削除します。

2.ノードを追加します。右クリック、Add Node→sampling→「KSampler」を追加します。NODE LIBRARYならそのまま「Ksampler」で検索すれば一番上に出てきます。

3.Add Node→conditioning→「CLIP Text Encode(prompt)」を追加します。すでにあるものをコピーしてもいいです。

4.「Load Diffusion Model」の右上「MODEL」というところから、「Ksampler」の左上「model」まで線を引きます。

5.「DualCLIPLoader」の「CLIP」から新しく追加した方の「CLIP Text Encode(prompt)」の「clip」につなぎます。

6.二つの「CLIP Text Encode(prompt)」の「CONDITONING」から、「KSampler」の「positive」「negative」につなぎます。

7.「Empty Latent Image」から「VAE Decode」につながっていると思いますが、これを「KSampler」の「latent_image」につなぎます。線を消したいときは線の真ん中にある丸をクリックして「Delete」を選択すれば接続を切ることができます。

8.最後に「KSampler」の「LATENT」から「VAE Decode」の「samples」に接続します。

9.あとは設定を微調整しましょう。「KSampler」の「steps」を4に「cfg」を1.0に変更しました。「Save Image」の表示も少し小さくしておきましょう。

これで実行すれば画像が生成されます。ノードを切り貼りして設定が少し変わっているのでサンプル画像に似た別の画像が生成されるはずです。

このように、画像を生成するのに決まった方法というのはありません。いろいろな試行錯誤が思わぬ結果をもたらすことでしょう。

ちなみに、Stable Diffusionになじんだ人だとcfgが1.0でいいということに驚くかもしれません。FLUXがもともとプロンプトへの追従性が高くつくられているため、それに対してcfgをいつもの感覚で7.0ぐらいにすると、過剰なまでにプロンプトに引きずられて色彩が狂ったり破綻したりしてしまいます。

また、schnellのような軽量化が施された蒸留モデルはstepsを上げてもクオリティの上昇には貢献しにくいです。少ない数字にしておいた方がタイムパフォーマンスがよくなりがちです。

ネガティブプロンプトもStable Diffusionほどは必要なく、よっぽど気になる要素があれば明記して除く程度で十分でしょう。

また、FLUXもLoRAを使用することができます。使いたい場合はAdd Node→loaders→「Load Lora」で追加し、「Load Diffusion Model」と「KSampler」の間、「DualCLIPLoader」と「CLIP Text Encode」の間になるようにつなぐだけです。

ただ、当然ですが、学習モデルの構造が全く違うため、Stable DiffusionとFLUXのLoRAはまったく互換性がありませんので注意しましょう。

構築したワークフローは左上の「Workflow」から「Save As」で保存することができます。

タブでいくつもワークフローを同時に開くこともできるので、用途に合わせた設定をそれぞれ保存しておくことをおすすめします。

以上がComfyUIの基本的な使い方になります。

よくある症状と対処方法

ComfyUIが起動しない

Stability Matrix側のログに「error while attempting to bind on address (‘127.0.0.1’, 8188): 通常、各ソケット アドレスに対してプロトコル、ネットワーク アドレス、またはポートのどれか 1 つのみを使用できます。」と出ていませんか?これは8188のポートが何かに使われていて、使用できなかった時に表示されるエラーです。大半は、閉じたつもりのComfyUIがまだ動き続けてしまっていることが原因です。

コマンドプロンプトを起動し、

netstat -ano | findstr :8188

と入力してみてください。(ポート番号は人によって違う場合がありますので、エラーログをよく確認しましょう)

そうすると、該当のポート番号が何に使われているかが出てきます。

(例)TCP 127.0.0.1:8188 0.0.0.0:0 LISTENING 12345

そうしたら、コマンドプロンプトで以下のコマンドを実行し、ポートを使用しているプログラムを強制的に終了させます。

taskkill /PID 12345 /F

これで改善します。

ComfyUIが動かなくなった

Stability Matrixのほうを確認してみましょう。こちらでComfyUIが止まってしまっていることがたまにあります。その場合は起動しなおしてみましょう。

インストールしたモデルが見つからない

起動中にインストールしたものを表示するにはブラウザを更新をする必要があります。この更新でStability Matrix上でComfyUIが止まってしまう可能性もあるので、併せて確認しましょう。

最後に

今回は「ComfyUI」を使って「FLUX.1」をローカルで運用する方法を紹介してきました。

画像生成に関する大まかな知識はStable Diffusionと共通するものが多いので、ぜひ過去の使い方ガイドも確認していただければ今回の記事で説明しきれなかったことも理解できるかもしれません。

FLUXも「Civitai」に多くのモデル(checkpoint)やLoRAが公開されています。schnellとdevの違いに気を付けながら、ライセンス等をしっかり確認したうえで利用しましょう。

また、なかにはNF4やGGUFといった「量子化」と呼ばれるモデルも存在します。容量も少なく、GPUへの負担も少ないのがメリットですが、やはりもともとのモデルの情報量はどうしても減ってしまうので、クオリティが落ちたり、LoRAの互換性が下がるなどのデメリットも相応にあります。

量子化モデルにはq8やq2といったq+数字がモデルの名前についていることがあります。これは数字が小さいほど軽量化されているということを表しています。

お手持ちのパソコンのスペックや、これから購入する際にはぜひ参考にしてみてはいかがでしょうか。

AIによる画像生成は意図せず第三者の著作権・肖像権・商標権などを侵害するリスクもあります。また、モデルデータや追加学習データによっては商用利用を禁止していたり、商用利用以外でも公開の際にクレジット表記が求められる場合もありますので、公開・商用利用の際は、各モデルの利用規約や関連する法律を必ず確認してください。

【関連記事】