オープンウェイトとは?オープンソースと何が違う?

AIのニュースを見ていると「オープンソースのAIモデル」という言葉をよく目にするかと思います。一方で、「オープンウェイトモデル」という言葉も見たことがあるのではないでしょうか。

「公開されていて自由に使えるもの」というイメージを持ちやすいですが、両者は根本的には全く違う概念です。

オープンソースとは

もともとソフトウェアの世界で使われてきた用語で、OSI(Open Source Initiative)が定義する、MITやApache 2.0などといったオープンソースライセンスに則って、ソースコードが公開され、誰でも利用・改変・再配布できるものを指します。

代表例はLinux(OS)やPython(プログラミング言語)などで、これらは世界中の開発者が自由に改良し、共有する文化を育んできました。

オープンウェイトとは

これは学習済みのモデルの「重み(weights)」が公開されている状態を指します。つまり、すでに学習されたモデルデータが公開されていることを示しており、ソースコードや元となるデータといった仕組みの部分がすべて公開されているわけではないということです。

LLaMA(2以降)やStable Diffusionといった有名なものを始めとして、公式にデータが配布されている多くのAIモデルが「オープンウェイト」に該当します。

なぜ混同されやすいのか

- オープンソース:自由に使える

- オープンウェイト:重みが公開されていて自由に使える

どちらも「自由に触れる」イメージを持つため、同じように思われがちです。

しかし本質は違います。

- オープンソース:仕組みそのもの(レシピ)が公開されている。利用・改変・再配布が自由に認められているもの。

- オープンウェイト:完成品(出来上がった料理)が配られている。これをどう利用できるかは各社が設けたライセンスによって制約がある可能性がある。

AIモデルの場合、重みこそが知識の実体なので、この学習モデルさえあれば、追加学習(ファインチューニング)させたり、アプリに組み込んだりなどの実用性が十分にありますが、透明性や自由度という点ではオープンソースとは根本的に異なります。

そもそも重みとは?AIの学習の仕組み

AIのニュースでは「パラメータが○○億」という数字がよく重要視されています。でも「パラメータ」とは、一体何の能力なのでしょうか?

ニューラルネットワークの仕組み

大規模言語モデル(LLM)は、人間の脳の神経回路を模した「ニューラルネットワーク」でできています。このネットワークの中には、数百万から数千億単位の「パラメータ(≒重み)」が存在します。

このパラメータとは、入力と出力をつなぐ「つながりの強さ」を表す数値です。

たとえば「猫」という言葉を聞いた時に、皆さんは何を思い浮かべるでしょうか?

「かわいい」「哺乳類」「飼育方法」「魚が好き」「アレルギー」「里親募集」「肉球」「ノルウェージャンフォレストキャット」…たくさん浮かぶと思います。人によっては「苦手」「怖い」「不愛想」かもしれません。

逆に、「電子レンジ」「キャベツ」「チワワ」「ボールペン」「化石」「充電式」などは、特殊な文脈がなければ直接は結び付かない単語です。

重みとは、その関連度合いを数値で表したもののことです。人間が脳内で自然に行っている「連想ゲーム」を再現しようとしているのがニューラルネットワークの仕組みです。

LLMの学習は、シンプルに言えば 大量の文章を読み込んで、この重みを最適化していく作業です。

- モデルが「次に来る単語」を予測する。

- 実際の正解と比べ、間違いがあればその分だけ重みを調整する。

- これを膨大な回数繰り返すことで、文脈を理解し自然な文章を生成できるようになる。

つまり、重みは「もっともらしい文章を作るための指標」にあたります。

学習とは「重みを調整すること」

例として文章生成AIにおけるニューラルネットワークを挙げましたが、画像生成も、音楽生成も、動画生成も、基本的にはこのニューラルネットワークの原理で学習されています。

砂嵐のようなノイズ画像の中から、どうやって色を残したり整えたりすれば猫に見えるようになるのか、どういう周波数が時間とともにどう変化すれば猫の鳴き声に聞こえるのか、猫が次にどういう動きをすれば歩いているように見えるのか、AIは膨大なデータをもとに繰り返し繰り返し学習していくことでその精度を高めていきます。

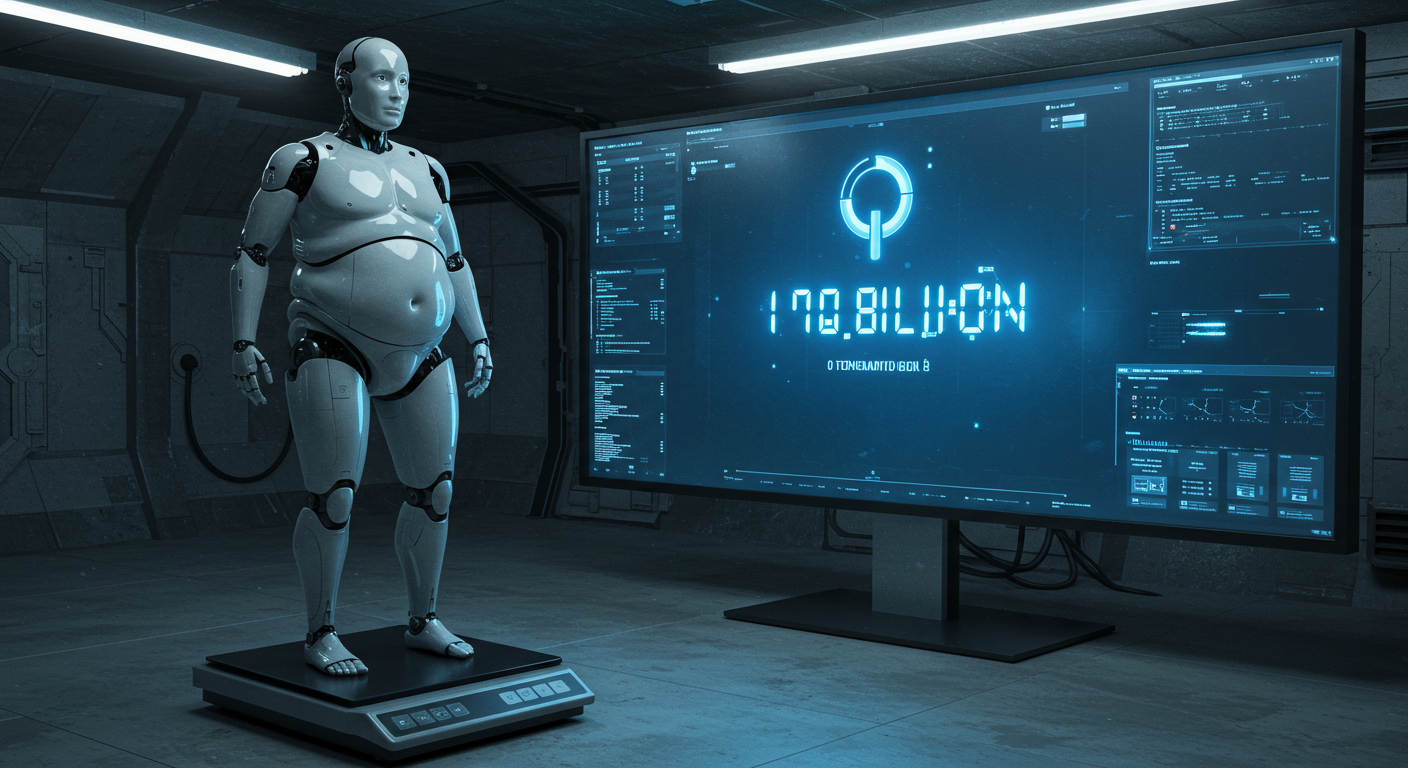

パラメータ数とモデルの規模

よく「◯◯億パラメータのモデル」と紹介されますが、これは簡単に言えば「モデルの中にいくつの重みがあるか」を表しています。

パラメータが多いほど、単語同士の関連性を深く学習しているということなので、表現力は高くなりますが、その分だけ学習コストや動作に必要な計算資源も増えます。

なので、学習済みのデータを公開するのです。学習前のデータは容量も膨大であり、学習する際に必要なGPUなどのスペックも大きく、学習も自体も効率よく行うようプログラムしなければ、どんなにデータが揃っていても高品質なモデルになるとは限りません。言ってしまえば、レシピだけ公開されても「直接それを調理、アレンジできる厨房やシェフは多くない」ということです。

また、世界中で「AIに無断で学習された」という訴訟が相次ぐ中、何を学習しているのかを公開することができる企業がどれだけいるのか?ということも示していると言えるでしょう。仮に権利的な問題のないデータセットを確保していたとしても、それを無料で公開できるかという点では同じでしょう。

結局、なぜオープンソースと呼ばれるのか?

先述の通り、「オープンソースAI」という言葉は広く使われていますが、その多くは実際には「オープンウェイトモデル」を指しています。

それでも「オープンソース」という言葉が使われるのは、

①「オープンソース」という言葉の方が一般的な認知度が高いから

②重みさえあれば使えるので「公開=オープンソース」と混同されやすいから

③マーケティング的に響きが良いから

という背景があります。

Hugging Faceなどでの開発者・研究者コミュニティの中では、この言葉遣いについての議論も起こっています。より実態を正確に表すために、ライセンスの制限内容を明記したり、「オープンモデル」や「公開モデル」といった中立的な表現を使おうという動きも見られます。

ですが、公開する企業が言葉のインパクトを重視して「オープンソース」という言葉を使っていて、報道する側もそれに倣って「オープンソース」として扱っているというのが現状です。

個人利用の範囲ではそこまで気にする違いではないかもしれませんが、オープンソースではないということは、その原則である「利用・改変・再配布の自由」の一部が認められていない場合もあるということです。

特に、企業などが商用利用する前には、改めてそれぞれの規約や、ライセンス等をよく確認することが重要です。