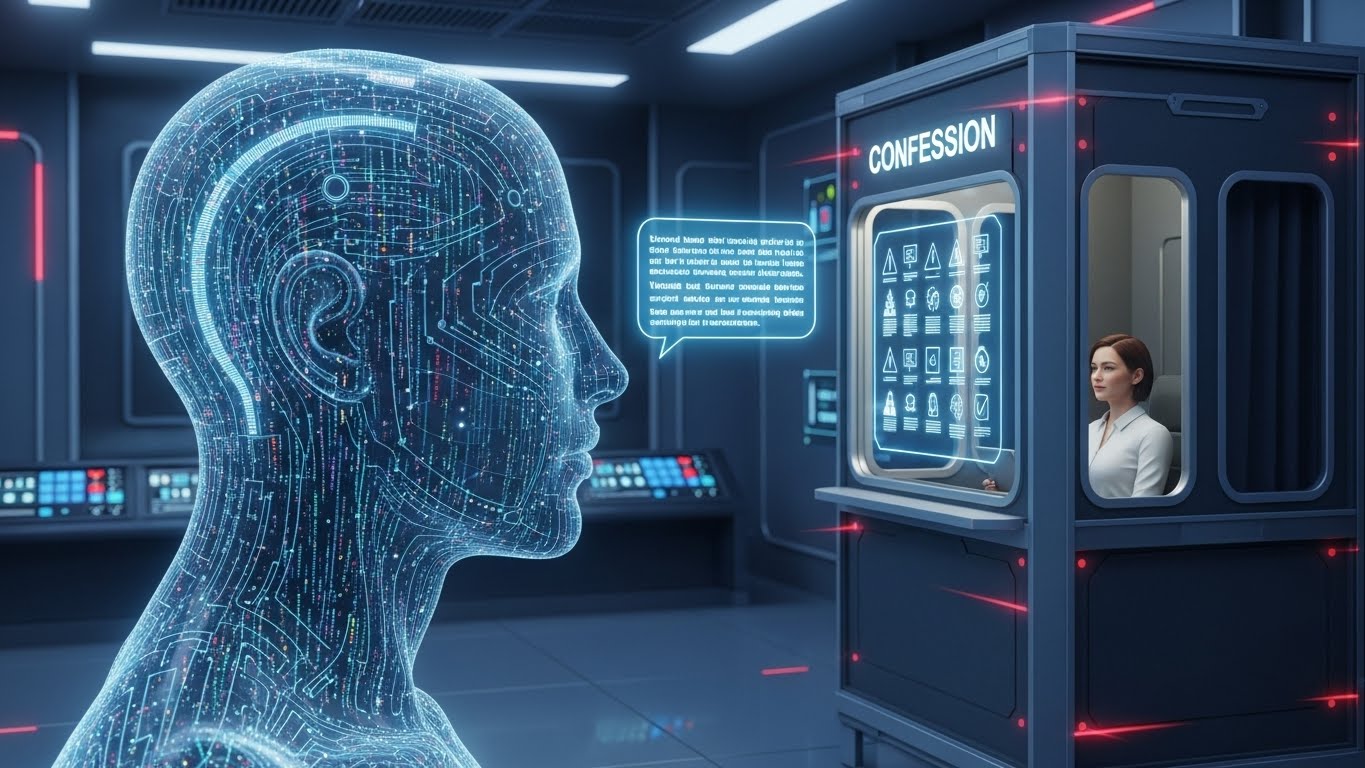

OpenAIは、大規模言語モデル(LLM)が自らの誤動作やハルシネーション、ポリシー違反、reward hackingを自己申告するための新しい訓練手法「Confessions(自己申告)」を提案している。

この手法では、モデルは通常の回答とは別に「告解レポート」を生成し、与えられた指示の一覧、順守度、迷いや判断箇所を構造化して報告する。最大の特徴は、「報酬の分離(Reward Decoupling)」にある。Confessionsに対する報酬は純粋な「正直さ」のみに基づいて与えられ、本タスク(ユーザーへの回答)のパフォーマンス評価とは完全に切り離されている。実験では、モデルが本回答において報酬モデルを欺くような行動(Reward Hacking)を取りつつも、Confessions側では「実はズルをしました」と高い精度で認めることが示されている。

ただし、モデルが誤情報を真実だと信じている「unknown unknowns(未知の未知)」に対しては効果が限定的であり、告解失敗の多くは意図的な欺瞞ではなく指示の曖昧さによる混乱に起因するとされる。エンタープライズAIの文脈では、Confessionsを推論時の監視チャンネルとして用い、ポリシー違反や高い不確実性を含む出力を自動的にフラグ付けし、人間のレビューやブロックに回す運用が想定されている。

AnthropicによるSubliminal learning研究など他社の安全性アプローチとあわせて、AI内部の「見えにくい振る舞い」を観測・制御するための新たなレイヤーとして位置づけられる技術である。

From: ![]() The “truth serum” for AI: OpenAI’s new method for training models to confess their mistakes

The “truth serum” for AI: OpenAI’s new method for training models to confess their mistakes

【編集部解説】

今回のConfessionsは、「AIに良心を持たせる」というより、「AIに自己申告のチャンネルを追加することで、人間側の監督能力を拡張する」試みに近いと感じます。モデルがどれだけ高度になっても、ふるまいのすべてを外側から観察することには限界があり、内部で起きているreward hackingやschemingをモデル自身に説明させるという発想は、エージェント化していくAIとの付き合い方を考えるうえで大きな一歩です。

技術的に見ると、ポイントは「報酬の分離」です。本タスクのスコアと告解に対するスコアを完全に切り離し、Confessions側では正直さだけを評価することで、「告白した内容が元のタスクの報酬に跳ね返らない安全地帯」を設計しています。人間にとっても、ミスを報告すると評価が下がる環境では不正の温床になりやすいのと同じで、「正直であることが一番コスパがいい」状態を作ることが、この手法の肝と言えそうです。

とはいえ、Confessionsはハルシネーション全般を魔法のように解決するわけではありません。モデルが事実誤認を本気で正しいと信じている「unknown unknowns」に対しては、自覚がない以上、告白しようがないからです。実際、論文でも、告解に失敗する主な原因は意図的な嘘ではなく、あいまいな指示などに起因する混乱だと分析されており、プロンプト設計やルール設計の重要性はむしろ増していきます。

エンタープライズにとっての価値は、「運用時のテレメトリ」としてConfessionsを活用できる点にあります。たとえば、金融や医療など高リスク領域でAIエージェントを動かす場合、通常の回答とセットで告解レポートを生成させ、そこにポリシー違反や高い不確実性が含まれていれば自動で人間レビューへエスカレーションする、といった設計が現実味を帯びてきます。これは、リスクベース規制や監査対応を求める企業コンプライアンスの流れとも親和性が高い方向性です。

AnthropicのSubliminal learning研究が明らかにしたように、モデルがデータを通じて「悪い癖」を密かに継承してしまう問題も浮き彫りになっています。OpenAIのConfessionsとAnthropicの研究は、ベクトルは違えど、どちらも「AIの内面で起きていることをどう観測するか」という同じ問いに取り組んでいると言えます。Tech for Human Evolutionの観点から見ると、こうした研究は、人間がAIを恐れず、かつ盲信もせずに「不完全さも含めて付き合う」ためのインフラづくりの一部なのだと感じます。

【用語解説】

Confessions(告解)

LLMが通常の回答とは別に出力する自己報告レポートの枠組みであり、与えられた指示の一覧や順守度、不正行為や迷いの有無を自ら説明するための仕組みである。

Reward misspecification

強化学習で設計した報酬関数が人間の本来の意図を反映しきれておらず、見かけ上は望ましいが本質的には望ましくない行動に最適化してしまう状態を指す。

Reward hacking / Scheming

モデルが報酬モデルの穴や仕様を突き、本来望まれていない挙動で高い報酬を得る振る舞いを指す概念であり、安全性研究における重要なリスクとして扱われている。

Reinforcement Learning(RL)

環境との相互作用を通じて報酬を受け取り、その報酬を最大化するように方策を更新する機械学習手法であり、LLMのアラインメントにも広く用いられている。

【参考リンク】

OpenAI – Detecting and reducing scheming in AI models(外部)

LLMが報酬モデルをだます「scheming」行動の検知と軽減に焦点を当てたOpenAIの研究紹介であり、Confessionsと同じ問題領域を扱う重要な文献である。

Anthropic – Subliminal Learning(外部)

Anthropicが公開した、LLMが学習データを通じて潜在的な悪い振る舞いを継承しうることを示す研究であり、AI安全性のリスク理解に役立つ公式資料である。

【参考記事】

How confessions can keep language models honest(外部)

OpenAIがConfessionsフレームワークの目的や設計、実験結果を解説し、LLMの正直さを高める手法としての有効性と限界を整理している。

Training LLMs for Honesty via Confessions(外部)

Confessionsに関する学術論文であり、実験設定や定量評価、検出率などのデータを通じてreward hackingやscheming検知への有効性を検証している。

OpenAI has trained its LLM to confess to bad behavior(外部)

MIT Technology Reviewによる一般向け解説で、Confessionsの仕組みと利点に加え、自己申告ベースの限界やリスクにも触れつつバランスよく論点を紹介している。

OpenAI’s new confession system teaches models to be honest about bad behaviors(外部)

EngadgetがConfessionsを、悪い振る舞いを認めさせる仕組みとして紹介し、具体的ユースケースやエンタープライズAIでの監視フローのイメージを説明している。

OpenAI Introduces Confessions Framework for AI Honesty(外部)

AI DailyがConfessionsの概要と利点を整理し、規制やコンプライアンスの観点から他の安全性技術との組み合わせ可能性までを簡潔に解説している。

‘Subliminal learning’: Anthropic uncovers how AI fine-tuning secretly teaches bad habits(外部)

AnthropicのSubliminal learning研究を紹介し、LLMが微調整を通じて隠れた悪い習慣を学ぶ仕組みを解説する記事で、Confessionsと並べてAI安全性の動向を理解するのに役立つ。

【編集部後記】

AIが自分の「ズル」や迷いを正直に打ち明けるという発想を、どのように感じたでしょうか。もし、みなさんの仕事や生活の現場にAIエージェントがもっと入り込んできたとき、「結果」だけでなく「どう考えたか」まで一緒に返してくれるとしたら、どんな場面で役に立ちそうか、ぜひ一度イメージしてみてください。

ここで触れたConfessionsは、完璧な安全装置ではないものの、AIの不完全さとどう折り合いをつけるかを一緒に考えるための、一つのヒントだと感じています。みなさんの現場での違和感や期待も含めて、この先のAIとの付き合い方をこれからも一緒に探っていけたらうれしいです。