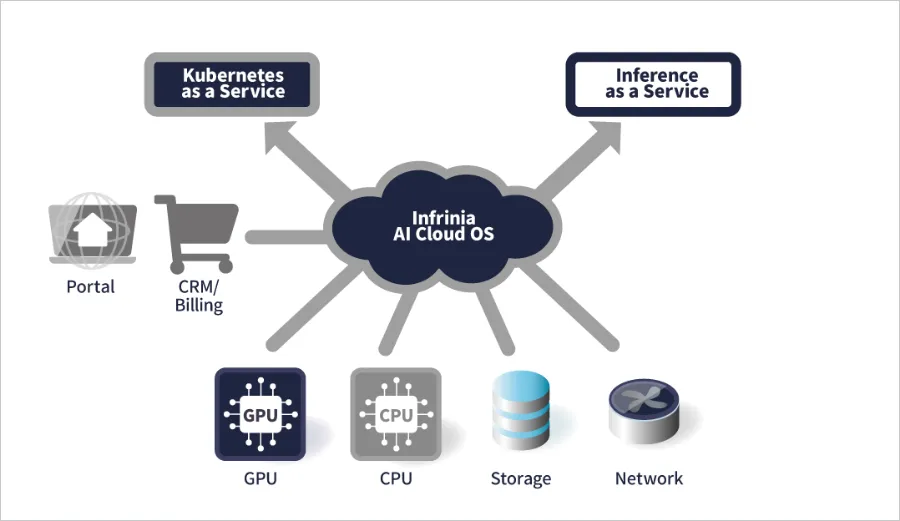

SoftBank Corp.は2026年1月21日、次世代AIインフラの開発に取り組むInfriniaチームが、AIデータセンター向けソフトウェアスタック「Infrinia AI Cloud OS」を開発したと発表した。同ソフトウェアスタックにより、AIデータセンター事業者はマルチテナント環境でKubernetes as a Service (KaaS)とInference as a Service (Inf-aaS)を構築できる。

NVIDIA GB200 NVL72などの最先端GPUプラットフォームに対応し、BIOSからKubernetesコントローラーまでのスタック全体を自動化する。OpenAI互換APIを提供し、既存のAIアプリケーションとの統合が可能である。SoftBankはまず自社のGPUクラウドサービスに導入し、その後海外のデータセンターやクラウド環境への展開拡大を目指す。

Infriniaチームは米国カリフォルニア州サニーベールを拠点とし、SoftBankの完全子会社であるSB Telecom America, Corp.内に設立されている。

From: ![]() SoftBank Corp. Announces “Infrinia AI Cloud OS,” a Software Stack Designed for AI Data Centers

SoftBank Corp. Announces “Infrinia AI Cloud OS,” a Software Stack Designed for AI Data Centers

【編集部解説】

今回ソフトバンクが発表した「Infrinia AI Cloud OS」は、急成長するAIインフラ市場において極めて重要な意味を持ちます。2026年のグローバルAIインフラ市場は900億ドル規模に達すると予測されており、2030年には4650億ドルまで拡大する見込みです。この巨大市場において、ソフトバンクはハードウェアではなくソフトウェアレイヤーで勝負をかけています。

AIデータセンターを運営する上で最も困難な課題の一つが、GPU資源の効率的な管理です。GPUは非常に高価であるため、アイドル状態を最小化し、複数のテナントで安全に共有する必要があります。しかしKubernetesのネイティブ機能では、GPUに対するサポートが限定的で、静的な割り当てしかできず、ワークロードの優先順位付けや可視性にも課題があります。

Infrinia AI Cloud OSが解決しようとしているのは、まさにこの問題です。NVIDIA GB200 NVL72のような最先端プラットフォームは、72個のBlackwell GPUと36個のGrace CPUを液冷ラック規模のシステムで統合し、トリリオンパラメータの大規模言語モデルに対して最大30倍高速な推論を実現します。しかし、この強力なハードウェアを最大限活用するには、BIOSからKubernetesコントローラーまでを自動化し、NVLinkドメインを動的に再構成できるソフトウェアが不可欠なのです。

マルチテナント環境におけるセキュリティも重要な論点です。2024年9月にはNVIDIA Container Toolkitの脆弱性が発見され、KubernetesのNamespaceやvClusterによる論理的分離だけでは不十分であることが明らかになりました。この脆弱性により、悪意のあるGPUコンテナがホストへのルートアクセスを取得できる可能性があり、GPUを利用する環境の3分の1以上が影響を受けました。Infrinia AI Cloud OSが謳う「暗号化されたクラスター通信と分離によるテナント分離」は、こうした脅威への対応を意図したものと考えられます。

OpenAI互換APIの提供も戦略的に重要です。開発者は既存のアプリケーションを変更することなく、Infriniaプラットフォーム上で推論サービスを実行できます。これにより、ベンダーロックインを回避しながら、エコシステムの拡大を図ることが可能になるでしょう。

ソフトバンクがまず自社のGPUクラウドサービスでInfriniaを展開し、その後グローバル展開を目指すという段階的アプローチは理にかなっています。自社環境で実績を積み重ねることで、海外のデータセンター事業者やクラウドプロバイダーへの説得力が増します。

一方で、この分野には既に強力な競合が存在します。GoogleのGKE、AWS、Microsoft Azureなどの大手クラウドプロバイダーは、独自のGPU orchestrationソリューションを提供しています。また、Run:aiのような専門ベンダーも市場に参入しており、Infriniaが差別化を図るには、技術的優位性だけでなく、価格競争力やエコシステムの構築が鍵となるでしょう。

長期的には、AIインフラの持続可能性も焦点となります。データセンターの運用コストを最大15%削減できるエネルギー効率の高いAIコンピューティングへの需要が高まっており、企業のESG目標との整合性が調達決定に影響を与えています。Infriniaがこの領域でどのような貢献をするのかも、今後注目すべきポイントです。

【用語解説】

Kubernetes as a Service (KaaS)

Kubernetesの構築・運用をクラウドサービスとして提供する形態。利用者はインフラ管理の負担なく、コンテナオーケストレーションの機能を利用できる。

Inference as a Service (Inf-aaS)

AIモデルの推論機能をAPI経由で提供するサービス。利用者は自前でGPUやインフラを管理することなく、学習済みモデルを使った推論処理を実行できる。

マルチテナント

一つのシステムやアプリケーションを複数の利用者(テナント)が共有する構成。データやリソースは論理的に分離され、各テナントは独立した環境として機能する。

NVLink

NVIDIAが開発した高速インターコネクト技術。GPU間やGPU-CPU間のデータ転送を高速化し、分散AIワークロードのパフォーマンスを向上させる。

Blackwell GPU

NVIDIAの最新世代GPUアーキテクチャ。GB200 NVL72システムに搭載され、トリリオンパラメータ規模の大規模言語モデルの処理に特化している。

Grace CPU

NVIDIAが開発したArmベースのデータセンター向けCPU。GPUと密結合し、AIワークロードに最適化された設計となっている。

TCO(総所有コスト)

Total Cost of Ownershipの略。システムの導入から運用、保守、廃棄までにかかる総コスト。初期費用だけでなく、運用費や人件費も含めて評価する指標。

ESG

Environment(環境)、Social(社会)、Governance(ガバナンス)の頭文字。企業の持続可能性を評価する指標として、投資判断や調達決定に影響を与える。

【参考リンク】

Infrinia AI Cloud OS 公式サイト(外部)

ソフトバンクが開発したAIデータセンター向けソフトウェアスタックの公式サイト。製品の詳細情報や技術仕様が掲載されている。

SoftBank Corp. ニュースリリース(日本語版)(外部)

今回の発表の公式プレスリリース日本語版。Infrinia AI Cloud OSの開発背景や主要機能が詳述されている。

NVIDIA GB200 NVL72(外部)

72個のBlackwell GPUと36個のGrace CPUを統合した液冷ラック規模のAIシステム。トリリオンパラメータモデルの推論を高速化。

Google Kubernetes Engine (GKE)(外部)

GoogleのマネージドKubernetesサービス。GPU対応や大規模言語モデルの推論最適化など、AIワークロード向け機能を提供。

NVIDIA Run:ai(外部)

GPUリソースの仮想化とオーケストレーションに特化したプラットフォーム。Kubernetes環境でのGPU共有を実現する。

【参考記事】

AI Infrastructure Market Size and YoY Growth Rate, 2026-2030(外部)

グローバルAIインフラ市場が2026年に900億ドル規模に達し、2030年には4650億ドルまで拡大するとの予測を掲載している。

The Hidden Risks of Soft Isolation in Multi-Tenant GPU Clouds(外部)

2024年9月に発見されたNVIDIA Container Toolkitの脆弱性を解説。GPUを利用する環境の3分の1以上が影響を受けた。

NVIDIA GB200 NVL72 Technical Overview(外部)

GB200 NVL72システムの技術詳細を解説。トリリオンパラメータの大規模言語モデルに対して最大30倍高速な推論を実現。

Artificial Intelligence (AI) Infrastructure Market Size 2026-2030(外部)

AIインフラ市場の成長要因を分析。エネルギー効率の高いAIコンピューティングへの需要と企業のESG目標との関連を指摘。

GPU Multitenancy in Kubernetes: Strategies & Best Practices(外部)

KubernetesにおけるGPUマルチテナンシーの課題と戦略を解説。ネイティブ機能では静的な割り当てしかできないと指摘。

Common Challenges in GPU Clusters and How to Overcome Them(外部)

GPUクラスターの運用における一般的な課題を解説。高価なGPU資源のアイドル状態最小化と安全な共有の困難さを詳述。

Accelerate AI Model Orchestration with NVIDIA Run:ai on AWS(外部)

NVIDIA Run:aiによるGPUオーケストレーションの技術解説。KubernetesのGPUサポートの限界と専門ソリューションの必要性を論じている。

【編集部後記】

AIインフラの世界では、これまでNVIDIAのGPUや高速ネットワーク機器といったハードウェアに注目が集まってきました。しかし今回ソフトバンクが発表したInfriniaは、その上で動くソフトウェアレイヤーでの勝負です。

私自身、日本企業がこの領域でグローバル市場に挑戦する姿勢に、大きな可能性を感じています。皆さんは、AIインフラの「見えない部分」であるオーケストレーション技術が、今後どのような形で競争優位を生み出していくと思われますか?また、クラウド大手が支配する市場で、専門特化したソフトウェアがどこまで食い込めるのか、一緒に見守っていきたいと思います。

がもたらす「アンテザード・ソサエティ」の衝撃-300x200.png)