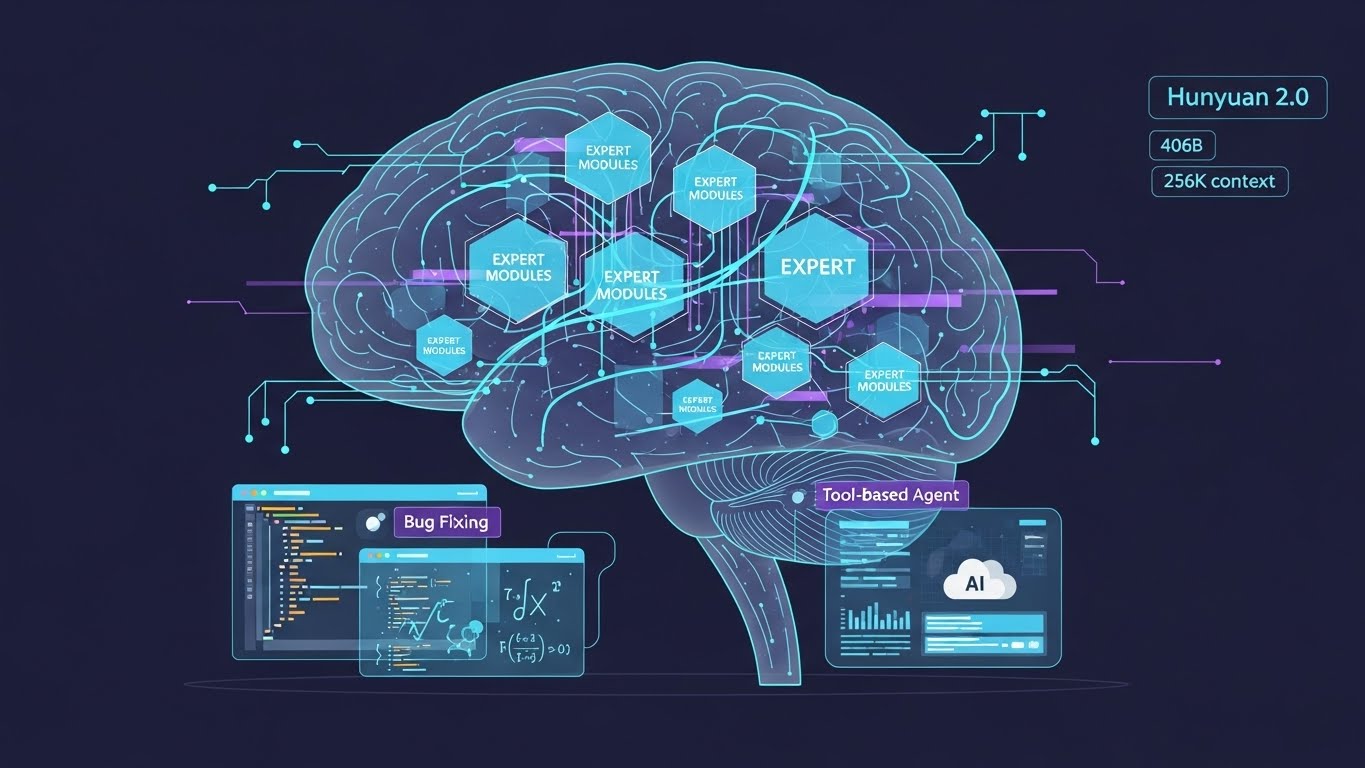

Tencentは2025年12月5日、自社開発の大規模言語モデル「HunYuan 2.0(Tencent HY2.0)」を発表した。 HY2.0はMixture of Experts(MoE)アーキテクチャを採用し、総パラメータ数406B、起動パラメータ32B、256Kコンテキストウィンドウを備えている。

改良版のHY2.0Thinkは、前バージョンHunyuan-T1-20250822と比較してプレトレーニングデータと強化学習戦略を見直し、数学・科学・コード・インストラクションフォローの複雑な推論タスクで国内トップクラスの性能と汎化能力を示している。

数学・科学分野ではLarge Rolloutによる強化学習を通じて推論能力を高め、IMO-AnswerBenchやHMMT2025、Humanity’s Last Exam(HLE)、ARC AGIといったベンチマークで高いスコアを達成した。 また、importance sampling correctionを用いたロングウィンドウRLにより、長文マルチターンの指示追従とタスク遂行の安定性も向上している。

コードおよびエージェント能力では、検証可能な環境と高品質な合成データの整備によりAgentic Codingやツール呼び出しタスクの実用性能を高め、SWE-bench VerifiedやTau2-Benchといった現実志向のベンチマークでスコアを押し上げている。

HY2.0とDeepSeek V3.2は、YuanbaoやimaなどTencentのAIネイティブアプリに組み込まれ、Tencent CloudのAPIおよびプラットフォームサービスとしても提供されている。

【編集部解説】

TencentのHunyuan 2.0は、単に大規模なLLMがもう一つ増えたという話ではなく、「推論」と「エージェント」という2つの軸が、実務レベルでいよいよ使い物になるフェーズに入ったことを示しているように感じる。 特に数学・科学系のベンチマークやSWE-bench Verified、Tau2-Benchといったタスクでスコアが伸びている点は、チャットボットから“問題解決エージェント”へのシフトが本格化しているサインだと捉えられる。

256Kコンテキストという長さは、仕様書やリポジトリ丸ごと、社内ナレッジ一式を読み込ませたうえで、AIに検討や修正案を任せるといったワークフローを現実の選択肢に押し上げる。 これにロングウィンドウRLやエージェントフレームワークが組み合わさると、「人が全体像を構想し、AIが具体的な手順を組み立てて実行する」という役割分担が、かなりの領域で成立しはじめるはずだ。

同時に、これだけ強力な推論・エージェント能力を持つモデルが、大規模なユーザーベースと結びつくことによるリスクも無視できない。 行動履歴に最適化された説得的なエージェントや、生成コンテンツを通じた価値観の微妙な誘導が、これまで以上にやりやすくなるからだ。 強力なモデルが登場するほど、透明性やログの検証可能性、人間側のガバナンス設計が問われていくことになる。

このニュースを眺めると、「中国勢のLLM競争」という表層を超えて、仕事の分解の仕方や、意思決定のどこを人間が握り続けるのかという設計の問題に目が向く。 AIに何を任せ、どこから先を任せないのかを、エンジニアリングやビジネスの現場ごとに具体的に決めていくことが、これからの数年で非常に重要なテーマになっていきそうだ。

【用語解説】

Mixture of Experts(MoE)

複数のサブモデル(エキスパート)を束ね、入力ごとに一部のエキスパートだけを動かすことで、総パラメータ数を増やしつつ計算コストを抑えるモデル構造のことだ。

256Kコンテキストウィンドウ

約25万6千トークンに相当する長さのテキストを一度に扱える入力長であり、長大なドキュメントやコードベースを丸ごと読み込ませて処理できることを意味する。

強化学習(Reinforcement Learning, RL)

モデルが報酬を最大化するように試行錯誤しながら方策を学ぶ機械学習手法であり、LLMでは推論の一貫性や指示追従性を高める目的で利用される。

Large Rollout

モデルに長い推論チェーンを生成させ、その過程を評価・フィードバックする形式の強化学習手法の総称であり、数学や科学の多段推論タスクに適している。

SWE-bench / SWE-bench Verified

実在のGitHubリポジトリのIssueやバグ修正タスクを用いて、LLMがどれだけソフトウェアエンジニアリングタスクを自動でこなせるかを測るベンチマークである。

Tau2-Bench(𝜏²-Bench)ツール呼び出しや外部システム連携を伴うテクニカルサポート・オペレーションを想定したエージェント評価用ベンチマークで、マルチツール・マルチステップの能力を測定することを狙っている。

Humanity’s Last Exam(HLE)

広範な一般知識と推論力を統合的に評価することを狙ったテストスイートであり、LLMの知識レベルと汎化能力を測る指標として用いられる。

ARC AGI

抽象的パターン認識と推論能力を評価するためのテストで、既存データへの単純な当てはめではなく、汎用性の高い推論力が求められるベンチマークである。

【参考リンク】

Tencent(外部)

中国・深圳を拠点とする大手テクノロジー企業で、SNS、ゲーム、フィンテック、クラウドなど多角的に事業を展開している。

Tencent Hunyuan(外部)

Tencentが提供する大規模AIモデル群の公式サイトで、言語やマルチモーダルモデルとクラウド向けAIサービスの概要を確認できる。

Tencent Cloud(外部)

インフラ、データベース、AIなどを提供するクラウドプラットフォームで、HunyuanシリーズやDeepSeek互換APIを含む各種AIサービスを利用できる。

DeepSeek(外部)

中国発の大規模言語モデルを開発する企業で、DeepSeek V3.2などのモデルをオープンエコシステムとして公開し、他社クラウドやアプリへの統合が進んでいる。

SWE-bench(外部)

オープンソースリポジトリのバグ修正タスクでLLMの開発能力を評価するベンチマークとリーダーボードを公開しているサイトである。

Tau2-Bench(外部)

ツール利用を前提としたAIエージェントのオペレーション能力を評価するベンチマークで、各種モデルのスコアとタスク概要を確認できる。

【参考記事】

Tencent HY 2.0: MoE Model with 73.4 IMO Reasoning(外部)

HY 2.0のMoE構造や406Bパラメータ、256Kコンテキスト、IMO-AnswerBenchやSWE-bench Verifiedのスコアなど技術的なポイントを詳細に整理した解説記事である。

Tencent Cloud DeepSeek OpenAI API(外部)

DeepSeek互換APIの公式ドキュメントで、利用可能なモデルやエンドポイント、料金体系を通じてHunyuanとの二枚看板戦略の一端を把握できる。

𝜏²-Bench Telecom Benchmark Leaderboard(外部)

Tau2-Benchでの各モデルのスコアと評価条件を一覧でき、エージェント型モデルのツール利用能力を他モデルと比較するのに役立つ。

【編集部後記】

Hunyuan 2.0のようなモデルが出てくると、「どこまでAIに任せてみるか」という問いが一気に現実味を帯びてきます。 みなさんの現場では、バグ修正やドキュメント整理、調査メモづくりなど、まずどのあたりからAIと分担してみたいでしょうか。

これからも一緒に、具体的なユースケースを言語化しながら、「未来の仕事のかたち」を少しずつ確かめていけたらうれしいです。