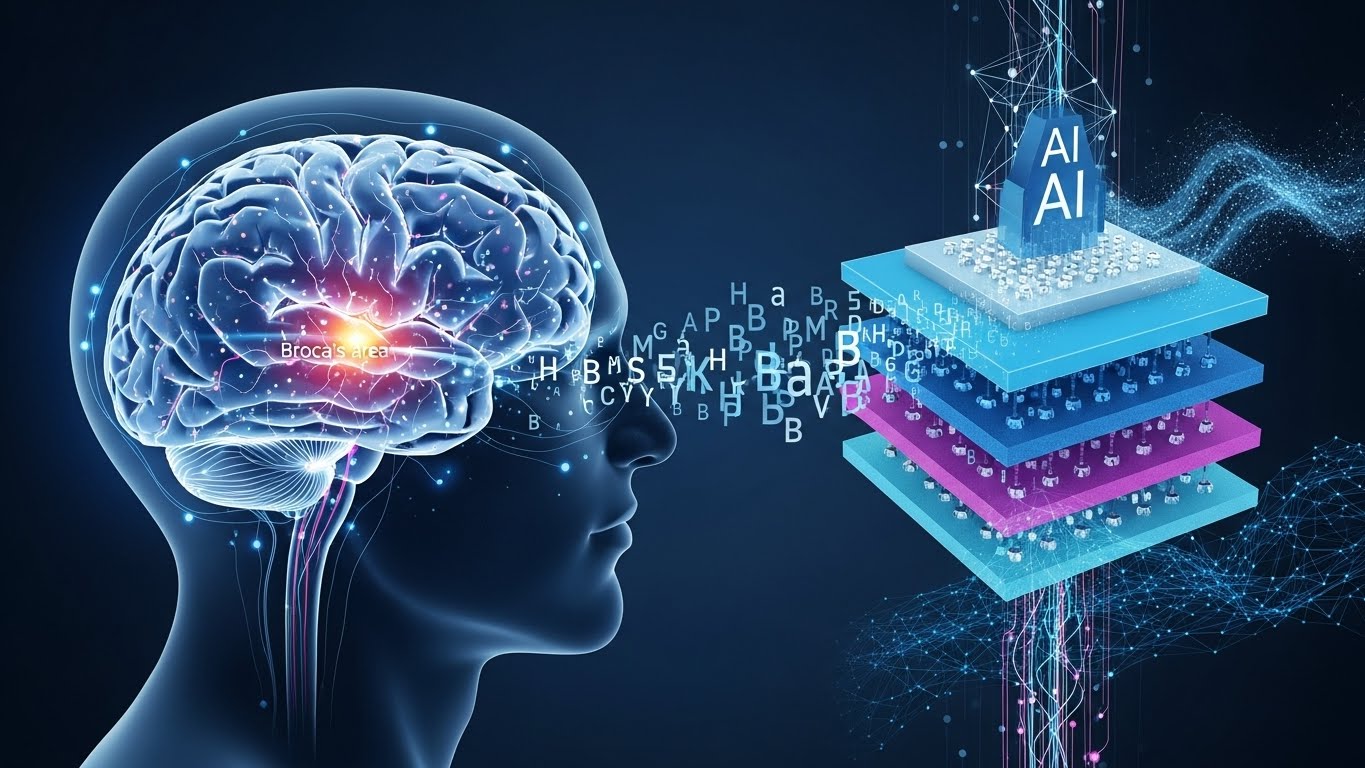

人間の脳は、言葉をどのように「理解」しているのでしょうか。

ヘブライ大学が公開した最新研究は、そのプロセスがGPT-2やLlama 2といった大規模言語モデルの内部構造と驚くほど似ている可能性を示しました。話し言葉を聞く脳の活動が、AIがテキストを分解し、文脈を積み重ねていく階層と時間的に対応していたという事実は、「AIは人間とまったく別物」という直感を静かに揺さぶります。

生成AIと付き合う時間が日常に溶け込みつつある今、「脳とAIのあいだ」で何が起きているのか。この研究は、その境界線をもう一度引き直すきっかけになりそうです。

ヘブライ大学のAriel Goldstein博士率いる研究チームは、Google ResearchのMariano Schain博士、プリンストン大学のUri Hasson教授、Eric Hamと共同で、人間の脳が話し言葉を処理する方法とAI言語モデルがテキストを分析する方法に驚くべき類似性があることを発見した。

Nature Communications誌に2025年11月26日に掲載されたこの研究では、30分間のポッドキャストを聞く参加者から皮質脳波記録法(electrocorticography)でデータを取得した。その結果、GPT-2やLlama 2などの大規模言語モデルの階層構造と脳の言語処理の時系列が一致することが明らかになった。

特にブローカ野などの高次言語領域では、AIモデルの深い層が脳の後期反応と対応していた。この発見は、言語理解が記号的ルールや厳格な言語階層に依存するという従来の理論に疑問を投げかけ、文脈に基づく動的で統計的なアプローチを支持するものである。

研究チームは言語特徴と対になった神経記録の完全なデータセットを公開し、世界中の科学者が人間の言語理解に関する競合理論を検証できるようにした。

From: ![]() How your brain understands language may be more like AI than we ever imagined

How your brain understands language may be more like AI than we ever imagined

【編集部解説】

この研究が持つ意味は、単に「脳とAIが似ている」という表面的な発見にとどまりません。むしろ、私たちが何十年も信じてきた言語理解のモデルそのものを根底から見直す必要性を示しています。

従来の言語学では、人間の脳は文法規則や音素、形態素といった記号的な要素を組み合わせて言語を理解すると考えられてきました。しかし今回の研究では、こうした古典的な言語特徴よりも、AIが生成する文脈的埋め込み表現の方が脳の実時間活動をより正確に予測できることが判明しています。

特に注目すべきは、時間軸に沿った処理の一致です。AIモデルの初期層は単語の単純な特徴を追跡し、深い層になるにつれて文脈や意味を統合していきます。脳もまったく同じパターンで、初期の神経反応はAIの初期層と、後期の反応は深い層と対応していました。ブローカ野では、AIの層が深くなるほど脳の反応ピークが遅れて現れるという、見事な相関関係が確認されています。

この発見が示唆するのは、言語理解が固定的なルールではなく、文脈に応じて流動的に意味を構築していくプロセスだということです。これは生成AIの登場以降、私たちが目の当たりにしてきた「大量のデータから統計的にパターンを学習する」という仕組みが、実は人間の脳が何百万年もかけて進化させてきた方法と本質的に近いことを意味します。

さらに重要なのは、研究チームが神経記録データを完全公開したことです。これにより世界中の研究者が同じデータセットを使って仮説を検証できるようになり、脳科学とAI研究の境界がさらに曖昧になっていくでしょう。人間の認知をより忠実に再現する次世代のAIモデル開発にも、この知見は直接的に貢献する可能性があります。

一方で、この研究は倫理的な問いも投げかけています。AIが人間の思考プロセスに近づくほど、AIの生成物を「理解」と呼んでいいのか、あるいは人間の創造性とは何が違うのかといった根本的な議論が必要になります。脳とAIの収斂が進む今だからこそ、私たちは技術と人間性の関係を改めて考える時期に来ているのかもしれません。

【用語解説】

皮質脳波記録法(Electrocorticography / ECoG)

脳の表面に電極を直接配置して神経活動を記録する手法。非侵襲的な脳波計(EEG)よりも高い空間解像度と時間解像度を持ち、言語処理などの詳細な脳活動を捉えることができる。主に外科手術の際に使用されるため、データ取得の機会は限られている。

大規模言語モデル(Large Language Models / LLMs)

膨大なテキストデータから学習し、文脈に応じた自然言語の生成や理解を行うAIモデル。GPT、Llamaなどが代表例で、複数の層(レイヤー)から構成され、各層で異なるレベルの言語特徴を処理する。

文脈的埋め込み(Contextual Embeddings)

単語やフレーズを高次元のベクトル空間に配置する表現方法。文脈によって同じ単語でも異なる埋め込み表現を持つため、意味の多様性を捉えることができる。AIモデルが言語を「理解」する際の基盤となる技術。

ブローカ野(Broca’s Area)

脳の前頭葉に位置する言語処理に関わる領域。主に言語の産出や文法処理を担当すると考えられてきたが、近年の研究では言語理解にも深く関与していることが明らかになっている。

音素(Phoneme)と形態素(Morpheme)

音素は言語の最小音声単位、形態素は意味を持つ最小単位。従来の言語学ではこれらの記号的要素が言語理解の基礎と考えられてきたが、本研究ではこれらよりもAIの文脈的表現の方が脳活動をよく説明できることが示された。

【参考リンク】

Nature Communications – 原著論文(外部)

脳の時系列的言語処理とAI言語モデルの階層構造の対応関係を詳述した査読済み原著論文

The Hebrew University of Jerusalem(ヘブライ大学)(外部)

本研究を主導したAriel Goldstein博士が所属するイスラエルの総合研究大学

Google Research(外部)

共著者Mariano Schain博士が所属するGoogleの研究開発部門

Princeton University(プリンストン大学)(外部)

Uri Hasson教授とEric Hamが所属する認知神経科学の世界的研究拠点

EurekAlert!(外部)

米国科学振興協会運営の科学ニュースリリース配信プラットフォーム

【参考記事】

Brain Uses AI-Like Computations for Language – Neuroscience News(外部)

30分のポッドキャスト視聴中の脳活動がGPT-2やLlama 2の処理階層と時系列で一致することを報告

Temporal structure of natural language processing in the human brain – Nature(外部)

電極配置、音声刺激、GPT-2とLlama 2の各層との相関分析結果を完全記載した原著論文全文

Hebrew U Study Reveals Our Minds May Process Language Like Chatbots – CFHU(外部)

Ariel Goldstein博士のコメントを引用し、脳とAIの段階的理解プロセスの収斂を強調

【編集部後記】

AIと会話するたび、ふと「この返答、本当に理解しているのかな?」と感じたことはありませんか。今回の研究は、その問いに新しい視点を与えてくれます。私たちの脳が言葉を理解する過程が、AIの処理構造と驚くほど似ているという発見は、技術と人間の境界線を改めて考えさせられるものです。

言語という最も人間らしい能力が、実は統計的で文脈依存的なプロセスだったとしたら、創造性や意識の本質とは何でしょう。みなさんは、この収斂をどう捉えますか?