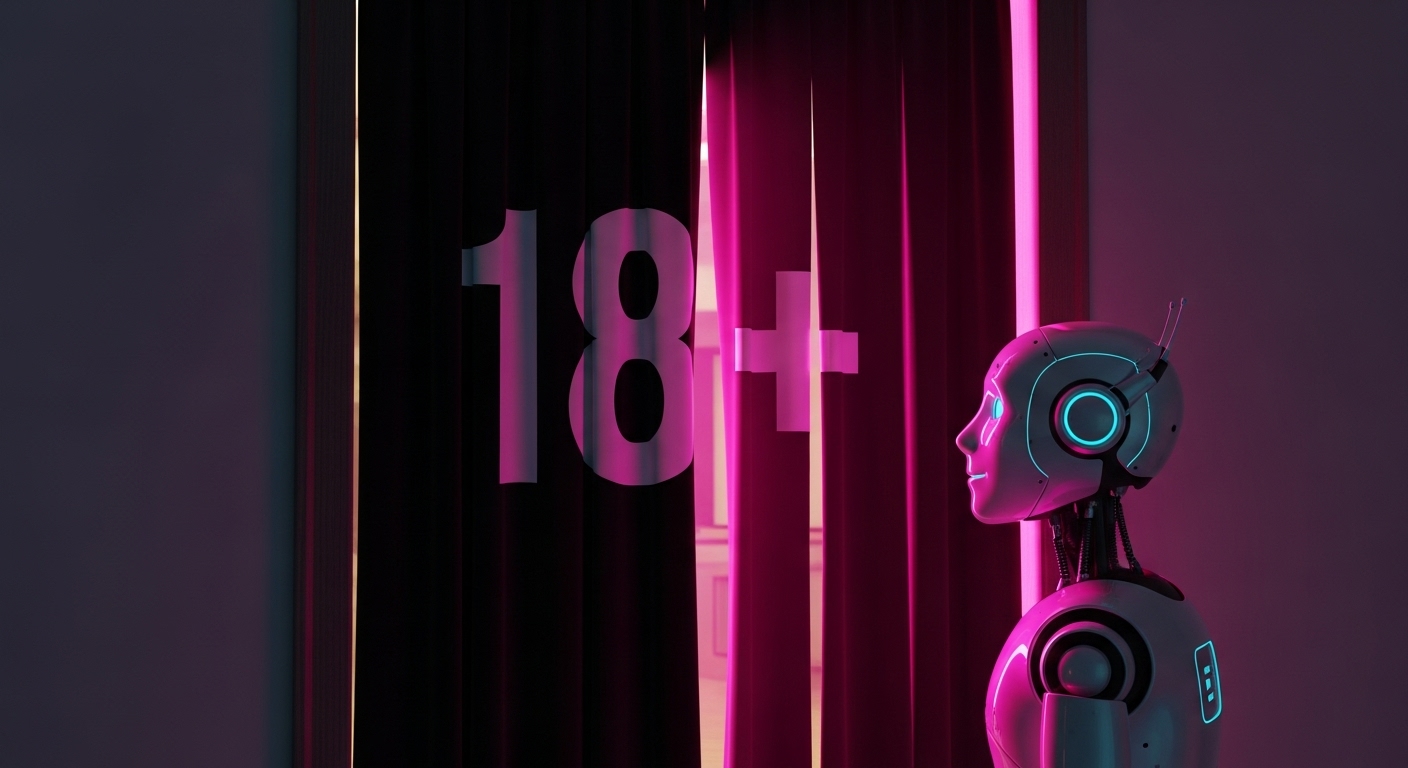

OpenAIのCEO、サム・アルトマンは2025年10月15日、対話型AI「ChatGPT」で成人ユーザー向けに性的なチャット機能を12月には解禁する方針を発表した。この方針は、サム・アルトマンがX(旧Twitter)上などで明らかにしたものである。

ChatGPTにはこれまで、未成年や精神的に不安定なユーザーなどへの配慮として、規制を強める方針をとっていたが、それが多くの一般ユーザーの体験を損ねていた面もあると主張した。

その上で、それらの規制に対する解決策があると述べ、新たな規制用ツールを用いて、段階的にユーザーの年齢や需要に寄り添った会話内容ができるようになると説明した。

そしてこの投稿が、大きな反響を呼んだことを受けて、改めて未成年や精神的に不安定なユーザーに対しては引き続き適切な制限をかけながら、成人向けの会話内容も、これまでと同様に社会的な倫理に反する内容は許可しないと念押しした。

【編集部解説】

インタラクティブなAIは、性的な話題に限らず、人の心に強い影響を及ぼします。とくに未成年や精神的に不安定なユーザーは、都合の良い応答を返すAIに人格を見出しやすく、孤立の固定化や依存、現実の対人関係の希薄化につながりかねません。

OpenAIは近頃、危機的な感情状態を検知して適切な応答へ振り分ける「セーフティ・ルーティング」やペアレンタルコントロールを打ち出しており、今回の方針はその保護策の上に位置づく動きです。とはいえ、実効性は実装と運用の質に大きく左右されます。

規制の緩和は、理屈より運用が難しい領域です。現在の厳格なモデレーションの下でも逸脱はゼロにできず、わずかな自由度の拡大が思わぬ誤用を誘発するリスクがあります。だからこそ段階的な導入は妥当で、実際のユーザー行動を観察しながら、検知モデルや人手レビュー、エスカレーション手順をチューニングしていく必要があります。保護者や教育現場からの反発や不信は、年齢ゲーティングの実効性が担保されなければ高まりやすい、という指摘も出ています。

今回注目すべき不確定要素は、年齢認証の方法と境界線の設計です。現段階では、どのようにユーザーの年齢を確認するのか、問題のある内容を規制するための新しいツールというのも、その正体は一切明らかになっていません。

法令やアプリストア(Apple、Google Play)のガイドラインに適合させながら、ID確認、決済連携、端末・家族アカウント等をどう組み合わせるのか。未成年がアクセスできないだけでなく、成人同士の“同意ある表現”と“有害・違法”をどう線引きし、ロールプレイや擬似恋愛のようなグレー領域をどう扱うのか。ここはプライバシーと安全の緊張関係が強く、監査やログ開示の透明性が信頼の鍵になります。

技術的・社会的な影響の射程は二面性があります。成人にとっては、文学的・教育的な文脈を含む“表現の幅”が広がり、過度な誤検知で対話が遮られるストレスは軽減されます。一方で、ディープフェイクポルノや同意のない性的コンテンツ拡散の温床にならないよう、ポリシーと検知の両輪が不可欠です。OpenAIはCSAMや未成年の性的対象化、未成年への不適切な露出を明確に禁止しており、このガードレールが維持されることが前提になります。

今後は「自由」と「保護」をどう両立させるかが試されます。

①年齢認証の実効性

②高リスクユーザーへの危機介入設計

③違反通報と是正プロセスの透明性

以上の三点が核心です。これらが十分に機能すれば、成人の表現の自由と、未成年の安全・福祉のバランスは現実的に取り得ます。逆に欠陥があれば、家庭や学校での利用は後退し、ブランド信頼の毀損は避けられません。

【用語解説】

セーフティ・ルーティング:

自傷や性的話題など高リスクの会話を検知し、安全度の高い処理系や人手レビューへ振り分ける仕組み。

年齢ゲーティング:

年齢情報にもとづく機能や表示、会話内容の切り替え設計。ペアレンタルコントロールとの併用前提

モデレーション:

規約違反や有害表現の検知・抑止とエスカレーションの運用全体。

CSAM(Child Sexual Abuse Material):

児童の性的虐待を描写する素材の総称。米国法上の「児童ポルノ」に相当する未成年を含む露骨な性的表現の視覚的描写を中核に、撮影・所持・配布・生成のすべてが違法対象。

【参考リンク】

OpenAI 公式サイト(外部)

生成AIの研究・提供企業の公式サイト。製品、安全ポリシー、研究情報を掲載。

OpenAI 使用ポリシー(外部)

未成年保護、CSAM・非同意コンテンツの禁止、執行方針の根拠文書。

Introducing parental controls(外部)

OpenAIの保護者向け設定の案内。未成年アカウントの連携と制御の概要。

NCMEC: CSAM(外部)

CSAMの定義、被害実態、通報枠組みの概説。米国の中核支援機関の資料。

【参考記事】

AI is overpowering efforts to catch child predators | The Guardian

AI生成画像の氾濫によりCSAM対策が逼迫する現状を解説。人手審査や制度設計の限界を指摘。

California governor vetoes bill to restrict kids’ access to AI chatbots | AP News

未成年とAIチャットの規制案を知事が拒否した背景と代替措置を整理。

Global Age Verification Measures: 2024 in Review | EFF

年齢確認制度の国際動向を俯瞰。プライバシー保護と表現の自由の観点から論点整理。

Generative AI CSAM is CSAM | NCMEC

生成AIが絡むCSAMの通報実態と検知・通報プロセスの要点を概説。

【編集部後記】

「性的な話題の解禁」という見出しが目を引くニュースですが、本質はそこではありません。アルトマン氏の意図は、守るべき人や倫理を守りながら、多様なユーザーが望む使い方に近づける。その設計の自由度をどう実現するかにあります。

当然、違法行為の助長や自傷の教唆のように、線を引くべき領域は明確にあります。性的な話題も未成年保護という観点や、社会的な孤独を強めるなど、リスクを伴います。一方で、リスクの高いテーマを増やすたびに一律禁止を積み上げていけば、最終的に語れる内容は痩せ細り、学びや創作や相談といった正当なニーズが置き去りになります。

私たちが問うべきは「何を禁じるか」ではなく、「どの文脈なら許容し、どう守るか」です。目的の明示(創作・教育・相談など)、年齢や同意の確認、危機介入や通報の導線、そして運用の検証と改善。派手な表現ではなく、この骨格を丁寧に積み上げることが、自由と保護の両立に直結します。

企業の責任は禁止事項を増やすことではなく、被害を確実に減らしつつ、正当な使い方を生かす設計を示し続けることだと考えます。理想的な倫理とは、自由の縮減で静けさを得ることではなく、透明なルールと実効性ある運用で信頼を積み上げるプロセスです。