AIが単行本10冊分以上の情報を同時に保持しながら作業できる時代が到来しました。Anthropicが2026年2月5日に発表したClaude Opus 4.6は、100万トークンのコンテキストウィンドウを搭載し、OpenAIのGPT-5.2を大きく上回る性能を実現。知識労働の概念そのものを変える可能性を秘めています。

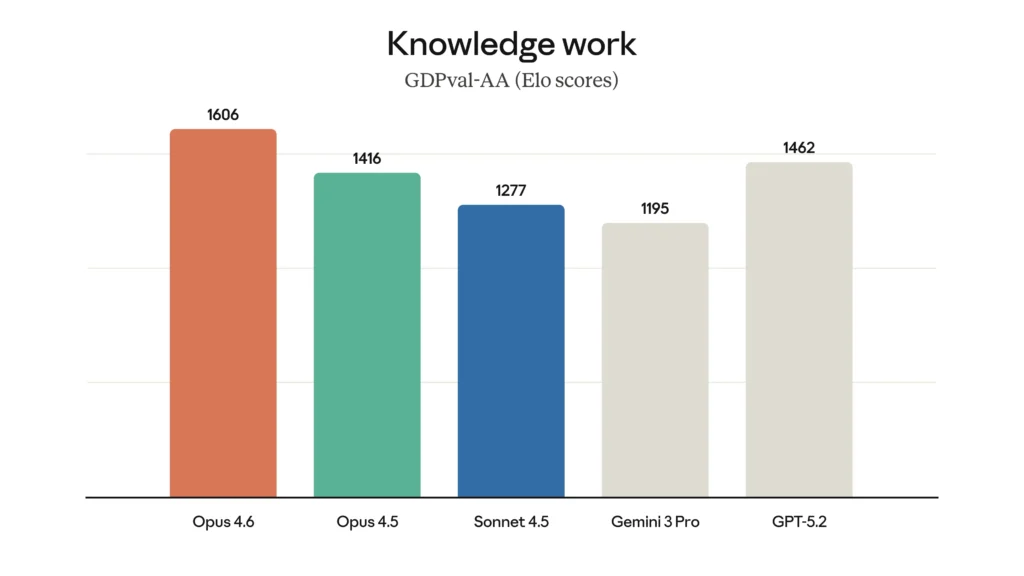

Anthropicは2026年2月5日、Claude Opus 4.6を発表した。このモデルはコーディング能力が向上し、Opusクラスで初めて100万トークンのコンテキストウィンドウをベータ版で搭載する。エージェントコーディング評価のTerminal-Bench 2.0で最高スコアを達成し、GDPval-AAではOpenAIのGPT-5.2を約144 Eloポイント、前モデルのClaude Opus 4.5を190ポイント上回った。

新機能としてadaptive thinking、4段階のeffort制御、context compaction、Claude Code内のagent teamsを導入した。最大出力トークンは128kに拡大された。価格は100万トークンあたり5ドル/25ドルで据え置き、20万トークンを超えるプロンプトには10ドル/37.50ドルが適用される。claude.ai、API、主要クラウドプラットフォームで利用可能である。

またClaude in Excelを大幅アップグレードし、Claude in PowerPointをリサーチプレビューとしてリリースした。

From: ![]() Introducing Claude Opus 4.6

Introducing Claude Opus 4.6

【編集部解説】

今回のClaude Opus 4.6は、AIモデルの進化において重要な転換点を示しています。最も注目すべきは、Opusクラスで初めて実装された100万トークンのコンテキストウィンドウでしょう。

100万トークンとは、日本語で約75万文字、英語なら約75万語に相当します。これは一般的な単行本10冊分以上の情報を一度に保持できる容量です。従来のAIモデルが抱えていた「コンテキストロット」という問題—会話が長くなると初期の情報を忘れてしまう現象—を大幅に改善したことになります。

実際、長文コンテキスト取得テストのMRCR v2では、Opus 4.6が76%のスコアを記録したのに対し、前世代のSonnet 4.5はわずか18.5%でした。この4倍の性能向上により、大規模なコードベース全体を把握しながらの開発や、膨大な法律文書・財務資料の横断的分析が現実的になります。

もう一つの革新が「adaptive thinking」と「effort制御」です。従来は推論を有効化するか無効化するかの二択でしたが、4段階(low/medium/high/max)の制御が可能になりました。モデル自身が問題の複雑さを判断し、必要に応じて深く考える時間を調整します。

これは開発者にとって極めて実用的な機能です。簡単なタスクで過剰な処理時間とコストをかけることなく、本当に難しい問題には十分なリソースを投入できるからです。つまり、知性・速度・コストの三者を状況に応じて最適化できる柔軟性を獲得したのです。

「agent teams」機能も見逃せません。Claude Code内で複数のAIエージェントを並行稼働させ、自律的に協調作業させることができます。大規模コードベースのレビューなど、分割可能なタスクを効率的に処理する仕組みです。

ベンチマークの数値も印象的です。GDPval-AAという実務タスク評価では、Opus 4.6はOpenAIのGPT-5.2を約144 Eloポイント、自社の前モデルOpus 4.5を190ポイント上回りました。これは知識労働における実用性で明確な優位を示しています。

Excel・PowerPointとの統合強化も戦略的な動きです。データ分析から視覚的プレゼンテーション作成まで、ビジネスワークフローの中核ツールで直接AIを活用できる環境が整いつつあります。

一方で、価格設定には注意が必要です。基本料金は100万トークンあたり入力5ドル/出力25ドルですが、20万トークンを超えるプロンプトには10ドル/37.50ドルのプレミアム料金が適用されます。100万トークンの恩恵を最大限受けるには、相応のコストを覚悟する必要があるでしょう。

安全性についても、Anthropicは慎重な姿勢を見せています。特にサイバーセキュリティ能力の向上を受けて、6つの新しい「probe(有害応答検出手法)」を開発し、悪用を防ぐ仕組みを強化しました。高度な能力と責任ある運用のバランスを取ろうとする姿勢が伺えます。

このリリースは、AIが「単なるチャットボット」から「自律的に長時間作業できる協働パートナー」へと進化していることを象徴しています。特に開発者やアナリストなど、大量の情報を扱う知識労働者にとって、作業の質と効率を根本から変える可能性を秘めているのではないでしょうか。

【用語解説】

トークン

AIモデルが処理するテキストの最小単位。英語では1単語がおよそ1トークン、日本語では1文字が約1.5〜2トークンに相当する。100万トークンは日本語で約75万文字、英語なら約75万語に該当し、一般的な単行本10冊分以上の情報量となる。

コンテキストウィンドウ

AIモデルが一度に記憶・参照できる情報の範囲。コンテキストウィンドウが大きいほど、長い文書や会話履歴を保持したまま応答できる。従来のモデルは数万〜20万トークン程度だったが、Claude Opus 4.6では100万トークンに拡大された。

コンテキストロット(context rot)

AIモデルが長い会話やテキストを処理する際、序盤の情報を忘れたり精度が低下したりする現象。「コンテキストの腐敗」とも呼ばれ、長文処理における大きな課題だった。

Eloレーティング/Eloポイント

もともとチェスの実力評価に使われていた相対評価システムで、AIモデルの性能比較にも応用される。2つのモデルを直接比較し、勝敗に応じてスコアを増減させる。約200ポイントの差があると、上位モデルが約76%の確率で優れた結果を出すことを意味する。

adaptive thinking

AIモデルが問題の複雑さを自動判断し、必要に応じて深い推論を行う機能。従来は推論機能のオン・オフしかできなかったが、状況に応じて最適な思考の深さを選択できるようになった。

effort制御

AIモデルの処理の深さを4段階(low/medium/high/max)で調整できる機能。簡単なタスクでは低いeffortで高速・低コストに処理し、複雑な問題では高いeffortで精度を優先するなど、用途に応じた最適化が可能。

context compaction

長時間の会話やタスクでコンテキストウィンドウの制限に達する前に、古い情報を自動的に要約・圧縮する機能。これにより、制限を超えることなく長期的なタスクを継続できる。

agent teams

複数のAIエージェントを同時に稼働させ、並行して作業を分担・協調させる機能。大規模コードベースのレビューなど、分割可能なタスクを効率的に処理できる。

Terminal-Bench 2.0

AIエージェントがターミナル環境で実際の開発タスクをどれだけこなせるかを評価するベンチマーク。89のタスクで構成され、実世界の開発シナリオを反映した難易度の高い評価指標である。

GDPval-AA

金融、法律などの専門領域における経済的価値の高い知識労働タスクでAIモデルの実用性を評価するベンチマーク。Artificial Analysisによって独立して運営されている。

MRCR v2

「needle-in-a-haystack(干し草の中の針)」と呼ばれる長文コンテキスト評価ベンチマーク。膨大なテキストの中に埋もれた情報をどれだけ正確に見つけ出せるかを測定する。

【参考リンク】

Anthropic公式サイト(外部)

Claude AIを開発するAI安全性研究企業。Constitutional AIなど独自技術を開発している。

Claude公式サイト(外部)

Claudeを直接利用できる公式Webインターフェース。ブラウザ上で対話や文書分析が可能。

Claude API ドキュメント(外部)

開発者向けの公式APIドキュメント。最新機能の実装方法や仕様が詳しく記載されている。

OpenAI公式サイト(外部)

GPTシリーズを開発するAI研究企業。Claude Opus 4.6と比較されるGPT-5.2を開発。

Terminal-Bench 2.0公式サイト(外部)

AIエージェントのコーディング能力を評価する業界標準ベンチマーク。89タスクで構成される。

【参考動画】

Anthropic公式YouTubeチャンネルによるClaude Opus 4.6の紹介動画。モデルの主要機能や改善点を簡潔に解説している。

【参考記事】

Claude Opus 4.6 vs 4.5 Benchmarks (Explained) – Vellum AI(外部)

Claude Opus 4.6と前モデル4.5のベンチマーク比較を詳細に分析した記事。

Anthropic launches Claude Opus 4.6 as AI moves toward a ‘vibe working’ era – CNBC(外部)

Claude Opus 4.6発表をAIの協働パートナー化という文脈で分析したCNBC報道記事。

1 million token context: The good, the bad and the ugly – Micron(外部)

100万トークンのコンテキストウィンドウのメリットと課題を技術的視点から解説。

Terminal-Bench 2.0: Raising the bar for AI agent evaluation – Snorkel AI(外部)

Terminal-Bench 2.0の開発背景と評価手法を詳細に解説した記事。

【編集部後記】

100万トークンという数字だけ見ると途方もなく感じますが、実際にあなたの仕事で扱っている資料の量と比べてみるとどうでしょうか。契約書、仕様書、過去のメール、レポート——それらをすべて同時に参照しながら作業できるとしたら、どんな使い方ができそうですか?

私自身も、AIが「質問に答えるツール」から「長時間一緒に働けるパートナー」へと変わりつつあることに驚いています。一方で、コスト面での現実や、本当に必要な場面の見極めも重要だと感じます。もしあなたがこの技術を実際に試す機会があれば、ぜひ体験を共有していただけると嬉しいです。

がもたらす「アンテザード・ソサエティ」の衝撃-300x200.png)