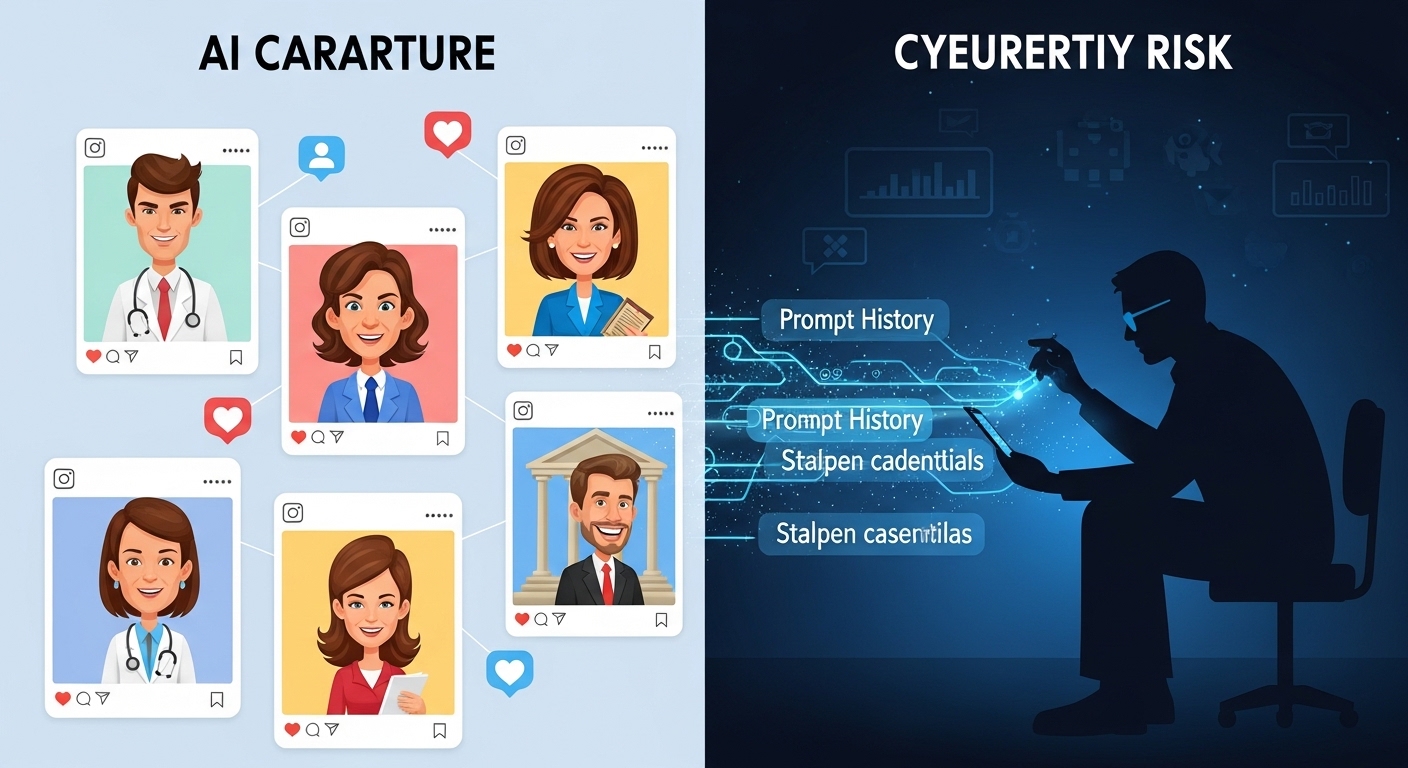

The Registerは2026年2月11日、AIが生成したカリカチュアをSNSに投稿するトレンドがセキュリティリスクをもたらすと報じた。Fortraのセキュリティアナリストであるジョシュ・デイヴィス氏によると、ChatGPTに「私について知っているすべてに基づいて私と仕事のカリカチュアを作成して」と依頼し共有する行為は、ソーシャルエンジニアリング攻撃、LLMアカウント乗っ取り、機密データ盗難のリスクを引き起こす。

2月8日時点で260万枚の画像がInstagramに投稿されており、銀行員、エンジニア、医師など多様な職業が確認されている。これらの投稿により、攻撃者はユーザーが業務でLLMを使用していることを把握でき、プロンプト履歴に保存された企業の機密情報にアクセスできる可能性がある。デイヴィス氏は、組織が従業員のLLM使用状況を可視化し、未承認アプリへのアクセスを制限するガバナンスポリシーの導入が必要だと指摘している。

From: ![]() Posting AI-generated caricatures on social media is risky, infosec killjoys warn

Posting AI-generated caricatures on social media is risky, infosec killjoys warn

【編集部解説】

一見すると無害に見えるこのAIカリカチュアトレンドですが、実は現代のデジタル社会が抱える複数のセキュリティ課題が交錯する地点に位置しています。

最も深刻な問題は、多くのユーザーがLLMのプロンプト履歴という概念を正しく理解していないことです。ChatGPTをはじめとする大規模言語モデルは、ユーザーとの会話履歴をすべて記録しており、この情報は次回以降の応答を改善するために活用されます。つまり「私について知っているすべてに基づいて」というプロンプトは、過去に入力したあらゆる情報へのアクセス許可を意味するのです。

このトレンドが示唆するのは、個人と企業の境界が曖昧になっている現実です。従業員の多くが業務支援のために個人のChatGPTアカウントを使用しており、そこには企業の機密情報、プロジェクトの詳細、顧客データなどが含まれている可能性があります。企業側はこうしたLLM使用状況をほとんど把握できていません。

攻撃者の視点から見ると、このトレンド参加者は格好の標的になります。ソーシャルメディアに投稿された画像から職業や所属企業を特定し、公開されているプロフィール情報と組み合わせることで、メールアドレスの推測やスピアフィッシング攻撃の準備が可能になります。デイヴィス氏が指摘するように、高度な技術力は必要ありません。

特に懸念されるのがLLMアカウント乗っ取りのシナリオです。ソーシャルエンジニアリング攻撃によってアカウントへのアクセスを得た攻撃者は、プロンプト履歴を検索して企業の機密情報を探すことができます。OWASPの調査によれば、プロンプトインジェクションは2025年時点でLLMアプリケーションの最も重大な脆弱性であり、本番環境の73%で確認されています。

このトレンドの危険性は、データの過剰共有を「常態化」させる点にもあります。楽しいエンターテイメントとして繰り返し個人情報をAIツールに入力することで、ユーザーは機密情報開示のリスクに対する感覚が鈍くなっていきます。サイバーセキュリティ研究者のオリバー・シモネット氏が提唱する原則、「公に共有しないものはAIプロンプトにも含めるべきではない」という基本的なルールさえ、見失われがちです。

企業が取るべき対策は明確です。まず従業員のLLM使用状況を可視化し、どのAIツールがどの企業データにアクセスしているかを把握する必要があります。その上で未承認アプリへのアクセスを制限するガバナンスポリシーを導入し、コンテキストベースのアクセス制御(CBAC)を実装することが求められます。

個人レベルでも対策は可能です。ChatGPTの設定でデータ共有をオフにする、プロンプトには一般的な情報のみを含める、AIツールを公共の場として扱い私的な告白者として扱わない、といった基本的な心構えが重要になります。

このトレンドは、AI技術が日常生活に浸透する過程で生じる新たなリスクの一例に過ぎません。私たちは今、便利さとセキュリティのバランスを再定義する歴史的な転換点に立っているのです。

【用語解説】

LLM(Large Language Model / 大規模言語モデル)

膨大なテキストデータで学習された大規模なAIモデルで、ChatGPTやClaudeなどがこれに該当する。自然言語を理解し生成する能力を持ち、会話、文章作成、翻訳など多様なタスクに対応できる。

プロンプトインジェクション

LLMに対して悪意のある指示を含む入力を与えることで、本来の動作を変更させる攻撃手法である。システムが設定した安全対策やルールを回避させ、機密情報の漏洩や不正な操作を実行させることができる。

ソーシャルエンジニアリング

技術的な脆弱性を突くのではなく、人間の心理や行動の隙を利用してシステムへの不正アクセスや情報窃取を行う攻撃手法である。フィッシングメール、なりすまし、信頼関係の悪用などが代表的な手口となる。

スピアフィッシング

特定の個人や組織を標的とした精密なフィッシング攻撃である。標的の職業、人間関係、趣味などの情報を事前に収集し、それに基づいて信憑性の高い偽メールを送信することで、認証情報の窃取やマルウェア感染を狙う。

Doxing(ドキシング)

個人の私的情報(本名、住所、電話番号、勤務先など)をインターネット上で無断公開する行為である。ソーシャルメディアやオープンソースインテリジェンスを活用して情報を収集し、嫌がらせや脅迫の目的で使用されることが多い。

CBAC(Context-Based Access Control / コンテキストベースのアクセス制御)

ユーザーの属性だけでなく、アクセス時の状況(時間、場所、デバイス、行動パターンなど)を総合的に判断してアクセス権限を動的に決定するセキュリティ手法である。LLMのような複雑なシステムでは、従来のロールベースの制御では不十分なため重要性が増している。

OWASP(Open Web Application Security Project)

Webアプリケーションのセキュリティ向上を目的とした国際的な非営利団体である。「OWASP Top 10」として知られる脆弱性リストを定期的に公開しており、LLMアプリケーション向けのTop 10も作成している。

【参考リンク】

Fortra(外部)

Web3セキュリティに特化したリアルタイム脅威検知ネットワークを提供するセキュリティプラットフォーム

OpenAI(外部)

ChatGPTを開発運営する人工知能研究企業。GPTシリーズやDALL-Eなどの先進的なAIモデルを提供

OWASP GenAI Security Project(外部)

生成AIとLLMアプリケーションのセキュリティリスクを特定し文書化するグローバルなオープンソースイニシアチブ

Lasso Security(外部)

LLMとAIアプリケーション向けの包括的なリスク管理プラットフォームを提供するセキュリティ企業

【参考記事】

AI caricature trend poses privacy risks, cybersecurity expert warns(外部)

UABのサイバーセキュリティ研究者によるAIカリカチュアトレンドの生体情報学習リスク分析

ChatGPT caricature trend privacy risks: What users must know(外部)

データ共有習慣の常態化とユーザーが過小評価する累積デジタル開示の危険性を詳述

ChatGPT’s Viral Caricature Trend Raises Privacy Concerns Among Experts(外部)

初週のサードパーティアプリダウンロード221%急増とセキュリティ専門家の警告を報告

LLM Security for Enterprises: Risks and Best Practices(外部)

NIST AIリスク管理フレームワークに基づく企業向けLLMセキュリティの包括ガイド

Prompt Injection Attacks: The Most Common AI Exploit in 2025(外部)

本番AI展開の73%で確認された第1位の脆弱性についての検知と防御戦略を提示

LLM Compliance: Risks, Challenges & Enterprise Best Practices(外部)

企業のLLMデータフロー把握の課題とGDPR、EU AI Act下のコンプライアンス要件を解説

LLM01:2025 Prompt Injection – OWASP Gen AI Security Project(外部)

プロンプトインジェクションの仕組みと直接・間接攻撃の違いを技術的に解説

【編集部後記】

私たちは今、AIとの付き合い方を社会全体で再定義する過渡期にいます。このカリカチュアトレンドは、新技術がもたらす楽しさと便利さの裏側に潜むリスクを、図らずも可視化してくれました。

皆さんご自身のデジタルフットプリントを振り返ってみてください。普段何気なく使っているAIツールに、どれほどの情報を預けているでしょうか。企業の方であれば、従業員がどのようにLLMを活用しているか把握できているでしょうか。

この記事が、デジタル時代のセキュリティについて考える一つのきっかけになれば幸いです。便利さを享受しながら安全を確保するバランス感覚こそ、これからの時代に求められるリテラシーなのかもしれません。

【関連記事】