Nvidiaは2025年12月1日、カリフォルニア州サンディエゴで開催されたNeurIPS AIカンファレンスにおいて、自動運転研究向けのオープン推論ビジョン言語モデル「Alpamayo-R1」を発表した。

同社は、これが自動運転に焦点を当てた初のビジョン言語アクションモデルであると主張している。このモデルは、2025年1月に初リリースされ8月に追加モデルが公開されたCosmosモデルファミリーのCosmos-Reasonモデルに基づいている。

Alpamayo-R1は、定義されたエリアと特定の状況下での完全な自律性を意味するレベル4自動運転の達成に重要な技術である。モデルはGitHubとHugging Faceで利用可能だ。また、開発者向けにステップバイステップガイド、推論リソース、ポストトレーニングワークフローを含むCosmos Cookbookも公開された。

From: ![]() Nvidia announces new open AI models and tools for autonomous driving research | TechCrunch

Nvidia announces new open AI models and tools for autonomous driving research | TechCrunch

【編集部解説】

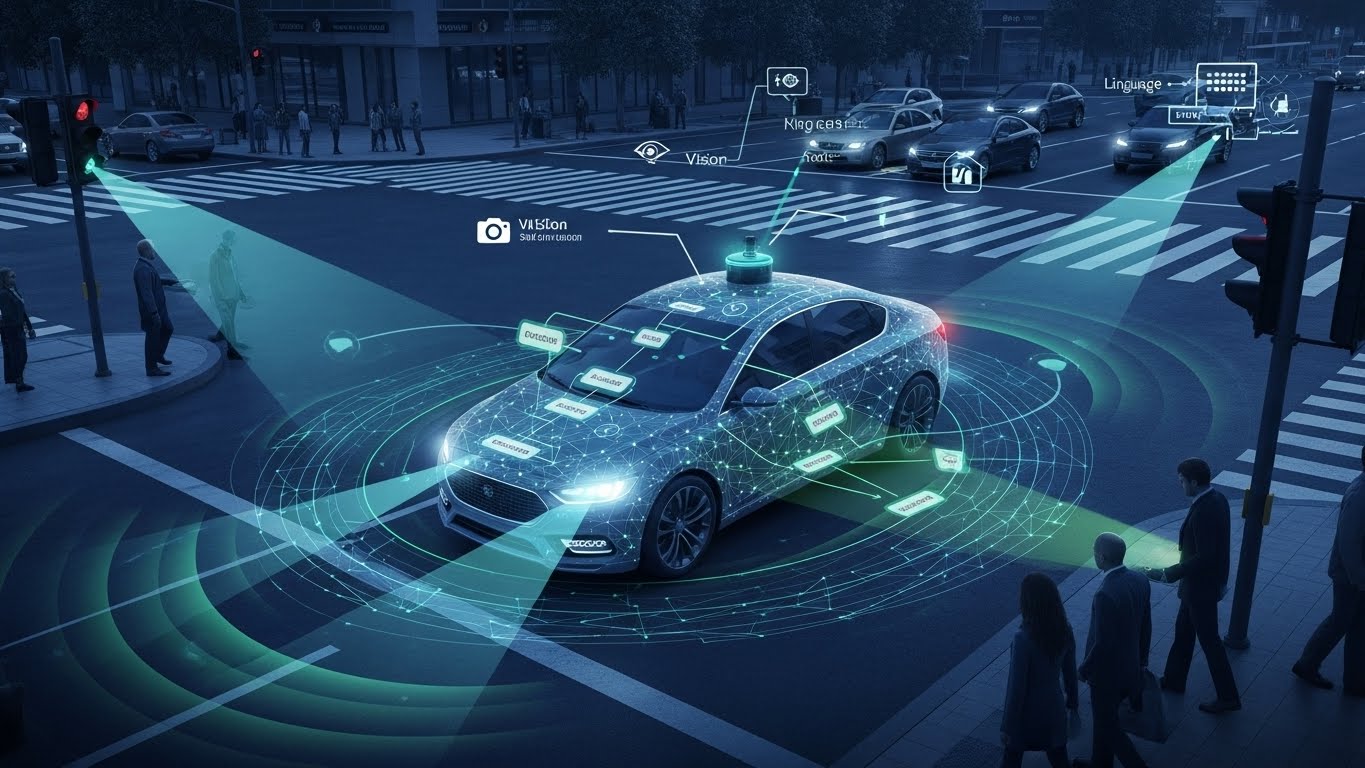

Nvidiaが発表したAlpamayo-R1は、自動運転技術における重要な転換点を示すモデルです。これまでの自動運転AIは、パターン認識に基づいて反応的に動作するものが主流でしたが、Alpamayo-R1は「推論」という新しい能力を自動運転に持ち込みます。

Vision-Language-Action(VLA)モデルとは、視覚認識、自然言語理解、行動生成を一つのフレームワークに統合したAIモデルです。ロボティクス分野ではGoogle DeepMindのRT-2やFigure AIのHelixなどが代表例ですが、Alpamayo-R1は自動運転に特化した世界初のVLAモデルとなります。従来のロボティクス用VLAモデルが物体操作や人間との協働に焦点を当てているのに対し、Alpamayo-R1は車両の経路計画と意思決定に最適化されています。

このモデルの最大の特徴は「Chain of Causation(因果連鎖)推論」を統合している点です。人間のドライバーが運転する際、私たちは「この車が減速しているから、前方に何か障害物があるかもしれない」「歩行者が道路脇にいるから、飛び出してくる可能性がある」といった多段階の推論を無意識に行っています。Alpamayo-R1は、この人間的な「常識」をAIに持たせることを目指しています。

具体的には、モデルは複雑な交通シーンを段階的に分解し、各ステップを推論しながら、可能な軌道を評価し、コンテキストデータを使用して最も安全なルートを選択します。これは、建設作業員が交差点に立っている、車線が塞がれている、雪道で視界が悪いといった複雑で予測不可能な状況下で特に有効です。

Nvidiaは、このモデルがレベル4自動運転の実現に不可欠だとしています。レベル4とは、定義された地理的エリアと特定の状況下で、ドライバーの介入なしに完全に自律走行できる段階を指します。現在、Waymoなどが限定的なエリアでレベル4のロボタクシーサービスを提供していますが、より広範な展開には、Alpamayo-R1のような推論能力が必要不可欠です。

重要なのは、このモデルがオープンソースとして公開されている点です。GitHubとHugging Faceで非商用利用向けに利用可能になっており、研究者はベンチマーク評価や実験的なAVアプリケーションの構築に活用できます。Nvidiaはまた、AlpaSimという評価フレームワークとCosmos Cookbookという開発者向けガイドも提供しており、研究コミュニティ全体の進歩を加速させようとしています。

さらに、Voxel51、1X、Figure AI、Foretellix、Gatik、Oxa、PlusAI、X-Humanoidなど、複数の企業がすでにCosmosモデルファミリーを採用しており、産業界での実用化が進んでいます。

このアプローチは、Nvidia CEO Jensen Huangが繰り返し述べている「物理的AIが次の波」という戦略と完全に一致しています。Nvidiaはこれまで、データセンター向けのAI GPUで大きな成功を収めてきましたが、今後はロボット、自動運転車、産業用AIといった「現実世界と相互作用するAI」が、同社の次の成長エンジンになると見ています。

ただし、課題もあります。推論モデルは計算コストが高く、リアルタイム制御には最適化が必要です。また、オープンソース化によって研究は加速する一方で、実際の商用展開にはNvidiaのハードウェア(高性能GPU)が必要となり、同社のビジネスモデルに組み込まれています。本質的に、Nvidiaはソフトウェアを無料で提供することで、ハードウェアの需要を喚起する戦略を取っているのです。

Alpamayo-R1の登場は、自動運転技術が「パターン認識」から「推論と理解」へと進化する歴史的な転換点となる可能性があります。

【用語解説】

Vision-Language-Action(VLA)モデル

視覚認識、自然言語理解、行動生成を統合したAIモデル。画像やビデオから視覚情報を取得し、言語命令を理解し、それに基づいて物理的な行動(ロボットの動作や車両の制御)を出力する。ロボティクスや自動運転の分野で注目されている次世代AI技術である。

Cosmos-Reason

Nvidiaが開発した推論モデル。応答する前に意思決定プロセスを段階的に考えるように設計されている。Alpamayo-R1の基盤技術となっており、物理的AI開発のための推論能力を提供する。

Chain of Causation推論

因果関係を連鎖的に推論する手法。複雑な状況を段階的に分解し、各ステップの因果関係を評価しながら最適な行動を決定する。人間が運転時に行う多段階の思考プロセスを模倣する。

レベル4自動運転(SAE Level 4)

SAE International(米国自動車技術者協会)が定義する自動運転の分類で、定義された地理的エリアと特定の状況下において、ドライバーの介入なしに完全自律走行が可能な段階。悪天候など条件外では運転できない制約がある。レベル5が無制限の完全自律運転であるのに対し、レベル4は限定的な条件での自律運転を指す。

NeurIPS

Neural Information Processing Systems(神経情報処理システム)の略。機械学習と人工知能に関する世界最大級の国際学会の一つ。毎年12月に開催され、最新のAI研究成果が発表される。

強化学習(Reinforcement Learning)

機械学習の一手法で、AIエージェントが試行錯誤を通じて環境との相互作用から学習する方法。報酬を最大化するように行動を最適化していく。Alpamayo-R1のポストトレーニングに効果的であることが確認されている。

物理的AI(Physical AI)

現実世界と物理的に相互作用できるAIシステムの総称。ロボット、自動運転車、産業用機械など、物理空間で動作し判断を行うAIを指す。デジタル空間のみで動作する従来のAIとは対照的な概念。

GitHub

ソフトウェア開発のためのプラットフォームで、オープンソースプロジェクトのコード共有やバージョン管理に広く使われている。開発者コミュニティの中心的存在。

Hugging Face

機械学習モデルとデータセットを共有するためのプラットフォーム。AI研究者や開発者がモデルを公開・利用・共同開発できるエコシステムを提供している。

【参考リンク】

NVIDIA Blog – At NeurIPS, NVIDIA Advances Open Model Development(外部)

NeurIPSでのAlpamayo-R1発表に関する公式ブログ。推論VLAモデルの技術詳細とCosmos Cookbookの情報を提供。

NVIDIA Research – Alpamayo-R1 Research Publication(外部)

Alpamayo-R1の研究論文ページ。技術的な詳細、評価結果、実車テストのデータを掲載。

NVIDIA Labs GitHub(外部)

NvidiaのオープンソースプロジェクトとAIモデルを公開するGitHubページ。Alpamayo-R1やCosmos Cookbookがダウンロード可能。

NVIDIA on Hugging Face(外部)

HuggingFaceのNVIDIA公式ページ。Alpamayo-R1モデルと関連データセットを提供。

SAE International – J3016 Levels of Driving Automation(外部)

自動運転の6段階分類を定義する国際標準。レベル0からレベル5までの詳細な定義を提供。

NVIDIA Newsroom – Cosmos World Foundation Models(外部)

Cosmosモデルファミリーの公式発表ページ。2025年1月のCESで発表された物理的AI開発プラットフォームの詳細情報。

【参考記事】

At NeurIPS, NVIDIA Advances Open Model Development for Digital and Physical AI(外部)

Alpamayo-R1の技術詳細、Cosmos-Reasonモデルとの関係、強化学習による性能向上、AlpaSimフレームワーク、採用企業の情報を掲載。

Alpamayo-R1: Bridging Reasoning and Action Prediction for Generalizable Autonomous Driving(外部)

Chain of Causation推論と軌道計画の統合、包括的評価の詳細。推論、軌道生成、安全性など複数の側面で最先端の性能を実証。

NVIDIA Makes Cosmos World Foundation Models Openly Available(外部)

Cosmosモデルファミリーの2025年1月リリースに関する詳細。9,000兆トークン、2,000万時間の実世界データでの訓練情報。

NVIDIA Autonomous Driving AI Gains Human-Like Reasoning(外部)

人間のような常識的判断を自動運転AIに導入する意義、パターン認識から文脈理解への進化について分析。

Vision-language-action model – Wikipedia(外部)

VLAモデルの一般的な定義、アーキテクチャ、Google DeepMindのRT-2やStanfordのOpenVLAなど主要モデルの説明。

SAE levels of automation in cars simply explained(外部)

SAE Internationalによる自動運転6段階分類の詳細説明。レベル4の定義とWaymo、Cruiseなどの実例を紹介。

NVIDIA launches Cosmos models, aims to expand physical AI(外部)

Jensen HuangによるCES 2025での発表内容、物理的AI市場の戦略的重要性、Omniverse統合による産業AI加速の展望。

【編集部後記】

自動運転車が「見る」だけでなく「考える」ようになる——Alpamayo-R1が示すこの方向性は、私たちの移動の未来を大きく変えるかもしれません。人間のドライバーが無意識に行っている「あの車が減速しているから、前方に何かあるかも」といった推論を、AIも持ち始めているのです。みなさんは、自動運転車にどこまでの「判断力」を期待しますか? そして、機械が人間のように「常識」を持つことに、どんな可能性と課題を感じるでしょうか。技術の進化を一緒に見守りながら、未来の移動体験について考えてみませんか。innovaTopia編集部も、この分野の動向を引き続き追っていきます。