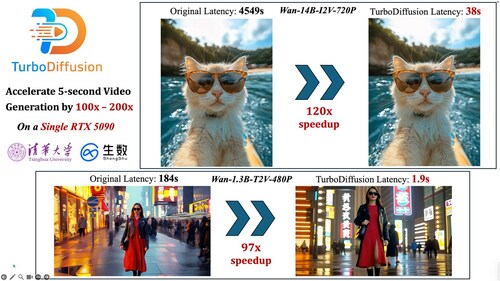

ShengShu TechnologyとTsinghua大学のTSAIL Labは2025年12月23日、AI動画生成を100倍から200倍高速化する新しい高速化フレームワークTurboDiffusionをオープンソース化したと発表した。このフレームワークは視覚品質をほとんど損なうことなく、リアルタイム動画生成を可能にする。

TurboDiffusionは低ビットアテンション高速化のSageAttention、17〜20倍の高速化を実現するSparse-Linear Attention、3〜4ステップで動画を生成する蒸留方法rCM、8ビット量子化による線形層高速化の4つの技術を組み合わせている。オープンソース動画生成モデル1.3B/14B-T2Vにおいて、単一のRTX 5090 GPU上で100倍から最大200倍のエンドツーエンド高速化を達成した。

ShengShu Technologyの動画モデルViduでは、1080p、8秒の高品質動画の生成時間が約900秒から約8秒に短縮された。SageAttentionはNVIDIAのTensorRTやHuawei Ascend、Moore Threads S6000に統合されており、Tencent Hunyuan、ByteDance Doubao、Alibaba Tora、Google Veo3、SenseTimeなどが採用している。

【編集部解説】

TurboDiffusionの発表は、AI動画生成技術の歴史において極めて重要な転換点を示しています。これまで動画生成AIは「できるかどうか」が焦点でしたが、今回の技術革新により「実用的な速度で高品質な動画を生成できるか」という次のステージへと進みました。

この技術が注目される最大の理由は、品質を犠牲にせずに100倍から200倍という劇的な速度向上を実現した点にあります。従来の拡散モデルは高品質な動画を生成できるものの、計算コストが非常に高く、実用化には大きな壁がありました。TurboDiffusionは4つの独立した技術を体系的に組み合わせることで、この課題を解決しています。

特筆すべきは、SageAttentionという低ビットアテンション高速化技術です。この技術はTsinghua大学のチームによって開発され、すでにNVIDIAのTensorRTに統合されるなど、業界標準として採用されつつあります。アテンション計算は拡散モデルの中核を担う部分であり、ここを8ビット量子化で高速化できたことの意義は計り知れません。FlashAttention2と比較して約2.1倍の演算速度を達成しながら、精度をほぼ損なわないという特性は、実用化の鍵となっています。

もう一つの重要な技術がrCMという蒸留手法です。通常の拡散モデルは数十から数百のステップを必要としますが、rCMを用いることでわずか3〜4ステップで高品質な動画を生成できます。これはNVIDIAが開発した最先端の蒸留方法であり、従来のsCMやDMD2といった手法が抱えていた品質と多様性のトレードオフを、スコア蒸留を組み合わせることで克服しています。

実用面での影響も看過できません。1080p、8秒の動画生成が約900秒から約8秒へと短縮されたことで、クリエイターはほぼリアルタイムで創作のフィードバックを得られるようになります。これは単なる時間短縮ではなく、創作プロセス自体の変革を意味します。試行錯誤を繰り返しながら作品を磨くという、これまで静止画や短い動画でしか実現できなかったワークフローが、より長尺の動画制作でも可能になるのです。

企業利用の観点からも、この技術は大きな可能性を秘めています。広告業界では複数のバリエーションを素早く生成して比較検討する需要がありますし、映画やアニメーション制作ではプリビジュアライゼーションの効率が飛躍的に向上します。計算コストの削減により、これまで大規模なGPUクラスタを必要としていた処理が、単一のRTX 5090で実行できるようになったことも、技術の民主化という観点で重要です。

一方で、この技術が社会に与える影響については慎重な議論も必要です。動画生成のハードルが下がることで、ディープフェイクなど悪意ある利用のリスクも高まる可能性があります。また、プロのクリエイターの仕事が代替される懸念も指摘されています。ただし、技術の進歩そのものを止めることは現実的ではなく、むしろ適切な規制とガイドラインの整備、そして人間の創造性を補完するツールとしての健全な発展を促すことが求められます。

オープンソース化されたことも、この技術の将来に大きな影響を与えるでしょう。GitHubで公開されたコードとモデルは、世界中の研究者や開発者がさらなる改良を加える土台となります。すでにMetaやOpenAIの研究者、vLLMなどの主要プロジェクトチームから注目を集めており、今後のエコシステムの発展が期待されます。

【用語解説】

拡散モデル(Diffusion Model)

画像や動画を生成するAI技術の一種。ノイズから徐々にデータを復元していく過程を学習することで、高品質なコンテンツを生成する。計算量が多く時間がかかるという課題があったが、高い生成品質で注目を集めている。

アテンション(Attention)

Transformerアーキテクチャの中核を担う計算メカニズム。入力データの重要な部分に注目して処理を行う仕組みで、計算複雑度がO(N²)と高いため、長いシーケンスを扱う際のボトルネックとなっていた。

量子化(Quantization)

ニューラルネットワークの計算精度を下げることで、処理速度を向上させメモリ使用量を削減する技術。32ビットや16ビットの浮動小数点数を8ビットや4ビット整数に変換することで、計算効率を大幅に改善できる。

蒸留(Distillation)

大規模な教師モデルの知識を、より小規模で高速な生徒モデルに転移させる技術。拡散モデルの文脈では、数十〜数百ステップ必要な生成プロセスを数ステップに削減するために用いられる。

Tensor Core

NVIDIA GPUに搭載されている、行列演算を高速化するための専用ハードウェア。低ビット精度の演算を効率的に実行できるため、量子化されたモデルの推論を加速する。

FlashAttention

アテンション計算を高速化するためのアルゴリズム。メモリアクセスパターンを最適化することで、GPUのハードウェア性能を最大限に引き出す。学術界と産業界で広く採用されている標準的な実装となっている。

INT8 / W8A8

8ビット整数を用いた量子化方式。W8A8は重み(Weights)とアクティベーション(Activations)の両方を8ビットに量子化することを意味し、計算速度の向上とメモリ使用量の削減を実現する。

TSAIL Lab

Tsinghua UniversityのStatistical AI and Learning研究室。機械学習、深層学習、統計的推論の基礎研究を行っており、特に効率的なAIモデルの開発で知られる。

vLLM

大規模言語モデルの推論を高速化するオープンソースライブラリ。PagedAttentionという独自の技術を用いて、メモリ効率と処理速度を大幅に向上させている。

DeepSeek Moment

中国のAI企業DeepSeekが発表した高効率なモデルが業界に与えた衝撃を指す表現。低コストで高性能を実現したことで、AI開発のパラダイムシフトを象徴する言葉として使われている。

【参考リンク】

TurboDiffusion GitHub リポジトリ(外部)

TurboDiffusionの公式リポジトリ。コード、モデル、ドキュメントがオープンソースで公開されている。

SageAttention GitHub リポジトリ(外部)

低ビットアテンション高速化技術SageAttentionの公式リポジトリ。FlashAttention2と比較して2〜5倍の高速化を実現。

Sparse-Linear Attention (SLA) GitHub リポジトリ(外部)

訓練可能なスパースアテンション技術のリポジトリ。SageAttentionと組み合わせて17〜20倍の高速化を実現。

rCM GitHub リポジトリ(外部)

NVIDIAが開発した最先端の拡散蒸留手法。3〜4ステップで高品質な動画を生成できる技術を公開。

Vidu 公式サイト(外部)

ShengShu TechnologyのAI動画生成プラットフォーム。世界200以上の国と地域で利用されている。

Vidu API プラットフォーム(外部)

Viduの開発者向けAPIプラットフォーム。企業やクリエイターが動画生成機能を自社サービスに統合できる。

Tsinghua University TSAIL グループ(外部)

Tsinghua大学の機械学習研究グループ。AI効率化技術やマルチモーダルモデルの基礎研究を実施。

【参考記事】

TurboDiffusion: Accelerating Video Diffusion Models by 100–200 Times(外部)

TurboDiffusionの技術論文。4つのコア技術を組み合わせて100〜205倍の高速化を実現する手法を詳細に解説。

SageAttention: Accurate 8-Bit Attention for Plug-and-play Inference Acceleration(外部)

SageAttentionの技術論文。8ビット量子化によるアテンション高速化でFlashAttention2の約2.1倍の演算速度を実現。

Large Scale Diffusion Distillation via Score-Regularized Continuous-Time Consistency(外部)

rCMの技術論文。最大14Bパラメータの大規模動画拡散モデルで1〜4ステップの高品質生成を可能にする。

Tsinghua-Affiliated DeepSeek: Silicon Valley in Frenzy as Single-Card 200x Acceleration Usher Videos into Sub-Second Era(外部)

TurboDiffusionの実用的な効果を解説。単一のRTX 5090 GPUで100〜200倍の高速化を達成したと報じている。

TurboDiffusion Releases Video Generation Acceleration Framework(外部)

TurboDiffusionの実装詳細と応用例を紹介。1.3Bモデルで約92倍、14Bモデルで約174倍の高速化を報告。

【編集部後記】

AI動画生成が「分単位」から「秒単位」へと変わる瞬間を、私たちは目撃しています。この技術がもたらすのは、単なる時間短縮ではなく、創作プロセスそのものの変革です。試行錯誤を重ねながらアイデアを形にしていく、そんなクリエイティブなワークフローが動画制作でも実現できる未来が見えてきました。

みなさんは、この技術をどのように活用したいと思いますか?個人のクリエイターとして表現の幅を広げるツールとして、あるいはビジネスでの新しい可能性として、さまざまな使い道が考えられます。一方で、技術の急速な進化は社会にどんな影響を与えるのか、一緒に考えていければと思います。

がもたらす「アンテザード・ソサエティ」の衝撃-300x200.png)