AIの回答を本当に信じていいのか――。その不安に対する答えが、Perplexityの「Model Council」です。Claude、GPT、Geminiなど複数の最先端AIモデルを同時に実行し、意見が一致する部分と分かれる部分を明示することで、「AIコンセンサス」という新しい信頼の形を提示します。

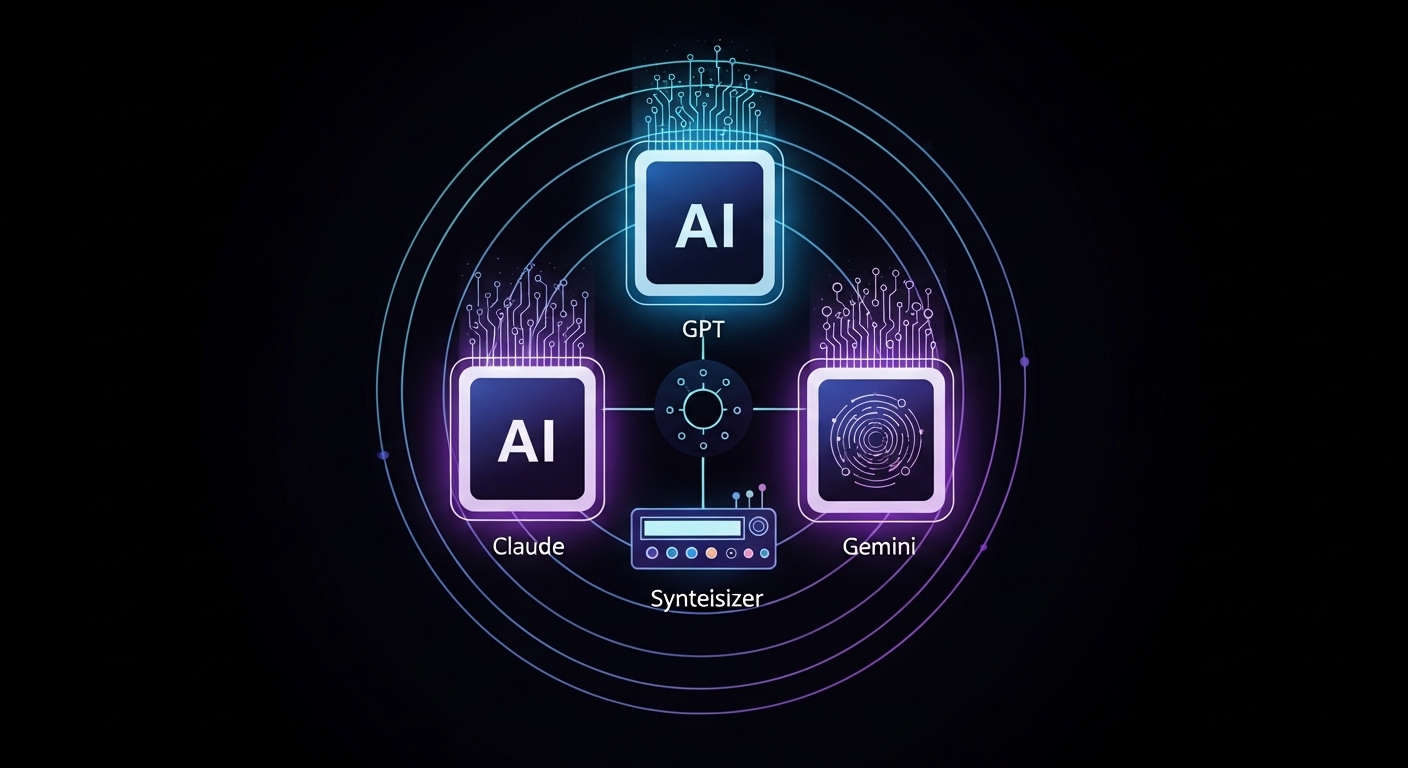

Perplexityチームは2026年2月5日、Model Councilという新機能を発表した。この機能は複数のAIモデルを同時に実行するマルチモデル・リサーチ機能である。ユーザーがPerplexityのメインインターフェースでModel Councilを選択すると、同じクエリがClaude Opus 4.6、GPT 5.2、Gemini 3.0など3つのモデルで一度に実行される。

シンセサイザーモデルが各モデルの出力をレビューし、矛盾を解決した上で、モデル間の一致点と相違点を示す統合された回答を提供する。投資リサーチ、複雑な意思決定、クリエイティブなブレインストーミング、情報検証などの用途を想定している。

Model CouncilはPerplexity MaxサブスクライバーがWeb上で利用可能であり、モバイルアプリのサポートは近日中に開始される予定である。

From: ![]() Introducing Model Council

Introducing Model Council

【編集部解説】

Perplexityの「Model Council」は、AI業界における重要なパラダイムシフトを示しています。従来、私たちは「どのAIモデルが最も優れているか」という問いに答えようとしてきました。しかしこの発表は、その問い自体が不適切だったことを示唆しています。

なぜ複数のモデルを同時に使う必要があるのか。それは、すべてのAIモデルには固有の「盲点」が存在するからです。MITとユニバーシティ・カレッジ・ロンドンの研究によれば、単一のAIエージェントでは算術精度が約70%に留まるのに対し、3つのエージェントを2ラウンド使用すると約95%まで向上することが確認されています。

特に注目すべきは、ハルシネーション(AIによる事実の捏造)への対策効果です。ある研究では、マルチモデルアプローチにより、用途に応じて18%から90%もエラーを削減できることが示されています。これは統計的に理にかなった結果で、複数の独立したモデルが同時に同じ誤情報を生成する確率は指数関数的に低下するのです。

Model Councilが提供する「シンセサイザーモデル」による統合メカニズムも興味深いポイントです。単純な多数決ではなく、各モデルの出力を精査し、矛盾を解決する仕組みは、AIが相互に批評し合う「協調的アンサンブル」とでも呼ぶべき新しいアプローチ。MIT研究では、AIモデルが他のモデルの回答が自身のものより優れていると認識する能力を持つことも確認されており、これがModel Councilの基盤となっています。

一方で、懸念点も存在します。計算コストは単一モデルの3倍以上となり、応答速度も低下する可能性があります。また、3つのモデルすべてが同じバイアスを共有している場合、そのバイアスはむしろ強化されてしまうリスクもあるでしょう。

投資判断や医療診断といった高リスク領域では、誤った情報のコストは計算コストを遥かに上回ります。Perplexityが投資リサーチを最初のユースケースとして挙げているのは、この点を理解しているからに他なりません。

長期的には、この「AIコンセンサス」のアプローチが業界標準になる可能性があります。2025年時点で78%の組織がAIを業務で使用している一方、77%がハルシネーションを懸念し、70-85%のAIプロジェクトが期待された成果を出せていない状況です。Model Councilのような技術は、この信頼性のギャップを埋める鍵となるかもしれません。

【用語解説】

Model Council

複数のAIモデルに同じ質問を同時に投げかけ、それぞれの回答を統合して1つの答えを返す機能。各モデルの強みを活かしながら、弱点を補完する仕組みである。

シンセサイザーモデル

複数のAIモデルから得られた異なる出力を分析し、矛盾点を解決しながら統合された回答を生成する役割を担うモデル。Model Councilにおいて各モデルの「調停者」として機能する。

ハルシネーション

AIが事実に基づかない情報を、あたかも真実であるかのように生成してしまう現象。日本語では「幻覚」とも訳されるが、AIが意図的に嘘をついているわけではなく、学習データのパターンから誤った推論を行った結果である。

アンサンブル

複数の機械学習モデルを組み合わせて、単一モデルよりも高い精度や安定性を実現する手法。統計学的に、独立した複数の予測を統合することでエラー率が低下する原理に基づいている。

バイアス

AIモデルが特定の視点や傾向に偏ってしまう現象。学習データの偏りや設計思想によって生じ、公平性を欠いた判断や予測につながるリスクがある。

【参考リンク】

Perplexity AI 公式サイト(外部)

AI検索エンジンを提供する企業。複数の最先端AIモデルへのアクセスを一つのプラットフォームで実現し、正確で引用付きの回答を提供する。

Claude(Anthropic)(外部)

Anthropic社が開発する大規模言語モデル。安全性と有用性を重視した設計が特徴で、長文の文脈理解や複雑な推論タスクに強みを持つ。

OpenAI(外部)

GPTシリーズを開発する人工知能研究機関。GPT 5.2はその最新世代モデルで、幅広いタスクに対応する汎用性の高さが特徴である。

Google Gemini(外部)

Google DeepMindが開発するマルチモーダルAIモデル。テキスト、画像、音声など複数の形式のデータを統合的に処理できる能力を持つ。

【参考記事】

How Teams Using Multi-Model AI Reduced Risk Without Slowing Innovation(外部)

マルチモデルAIによるリスク削減効果を分析。算術精度70%が95%に向上、ハルシネーション削減18-90%という具体的数値データを提示。

Consensus Reliability Stack: Trust via Multi-Model Agreement(外部)

複数モデルの合意による信頼性向上のメカニズムを解説。独立した複数モデルが同時に誤る確率の指数関数的低下について論じる。

Blind Spots: How AI Mirrors and Magnifies Human Bias(外部)

AIモデルの盲点とバイアスの構造を技術的に分析。単一モデル依存のリスクと複数モデルによるバイアス可視化の可能性を論じる。

【編集部後記】

みなさんは普段、AIツールを使う際に「このモデルの回答、本当に正しいのかな?」と不安になったことはありませんか。私自身、重要な判断の前には複数のAIに同じ質問を投げかけて、答えを見比べることがよくあります。Model Councilは、その手間を自動化してくれる機能です。

投資判断やキャリアの選択といった「間違えられない場面」で、どのような使い方ができそうか。みなさんならどんなシーンで活用してみたいですか。AIの答えを「信じる」から「検証する」へ。その一歩を一緒に考えてみませんか。

がもたらす「アンテザード・ソサエティ」の衝撃-300x200.png)